Mistral AI發佈Mixtral 8x7B:革新機器學習的SMoE語言模型,性能媲美GPT-3.5

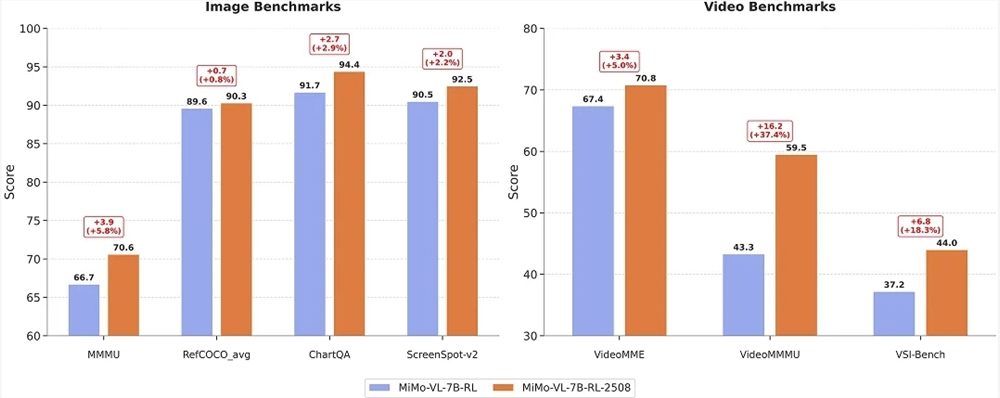

小米大模型團隊宣佈開源最新一代多模態大模型 Xiaomi MiMo-VL-7B-2508,包含 RL 與 SFT 兩個版本。 官方數據顯示,新版模型在學科推理、文檔理解、圖形界面定位及視頻理解四項核心能力上全面刷新紀錄,其中 MMMU 基準首次突破70分大關,ChartQA 升至94.4,ScreenSpot-v2達92.5,VideoMME 提升至70.8。

PyTorch 2.8正式發佈,重點提升量化大語言模型在Intel CPU上的推理性能,支持A16W8等多種量化模式,測試顯示端到端延遲降低20%以上。新增對Intel GPU分佈式後端的實驗性支持,擴展硬件兼容性。其他改進包括:SYCL支持增強C++擴展API、XPU設備新增A16W4模式、穩定libtorch ABI接口、增強ROCm支持並新增gfx950架構。新版本還優化了控制流操作,提升模型編譯效率。下載地址:https://github.com/pytorch/pytorch/releases/tag/v2.8.0

初創公司Lava Payments獲580萬美元種子輪融資,致力於構建AI代理支付系統。創始人米切爾·瓊斯發現現有支付方式阻礙AI代理流暢交易,遂開發通用積分錢包解決方案。該系統允許用戶預存積分,AI代理可在支持Lava的商戶和AI模型間直接扣款,無需逐筆授權。Lerer Hippeau領投本輪融資,資金將用於團隊擴充和產品開發。瓊斯出身工薪家庭,曾創辦多家金融科技公司,希望讓AI支付更普惠。

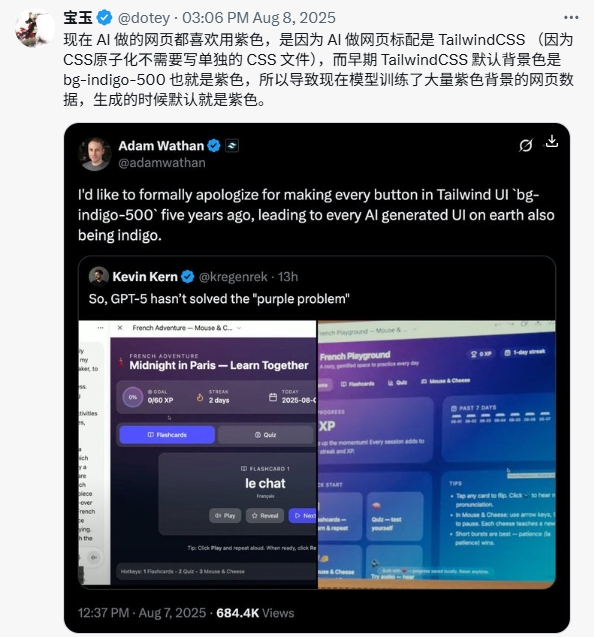

本文分析了當前AI生成用戶界面中普遍存在的紫色主題現象,探討其根源、技術成因及對未來UI設計的潛在影響。研究表明,這一現象源於Tailwind CSS框架的默認配色方案在AI訓練數據中的過度表示,揭示了人類設計決策如何通過機器學習模型的訓練過程產生意外的長期影響。

Cursor宣佈限時免費提供GPT-5使用權,付費用戶可獲得一定額度。GPT-5在編碼、數學等任務表現優異,超越Claude Sonnet4等模型,特別擅長軟件工程和多步驟工作流。同時Cursor推出CLI命令行工具,支持開發者通過命令行調用AI功能生成和優化代碼。GPT-5具備深度推理能力、高效API支持和出色的代碼生成調試功能,在LMArena榜單排名第一。這一系列更新被視爲Cursor鞏固市場優勢的戰略舉措,已在開發者社區引發熱烈討論。

dots.ocr是一款1.7B參數的輕量化多語言文檔解析模型,在OCR領域表現突出。其特點包括:1)輕量高效,處理單頁PDF僅需數秒;2)支持100種語言,低資源語言處理優勢明顯;3)精準識別文檔佈局元素並保持閱讀順序;4)表格和公式解析能力突出,可輸出LaTeX格式。適用於文檔數字化等場景,但在處理複雜表格、圖片內容時仍有侷限。該模型以輕量化設計打破傳統OCR侷限,展現了文檔解析技術的新高度。