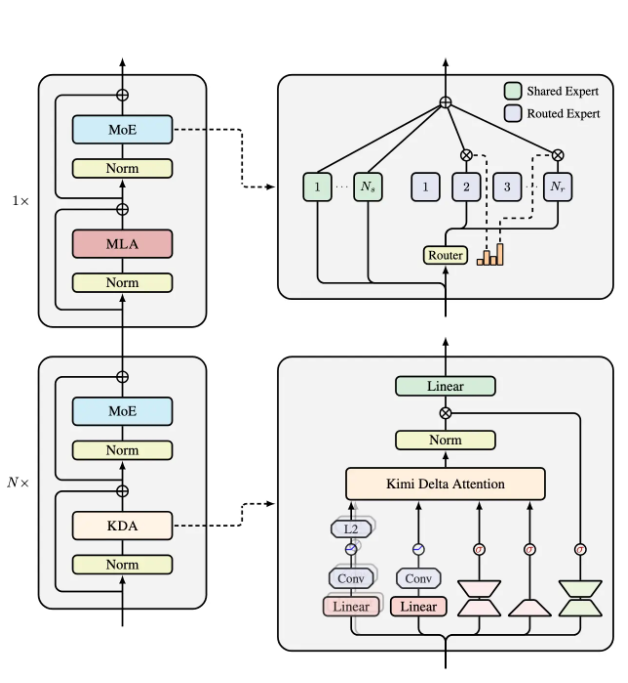

近日,月之暗面發佈了一種全新的混合線性注意力架構,名爲 “Kimi Linear”。這一架構據稱在處理短距離、長距離信息以及強化學習(RL)等多種場景中,性能優於傳統的全注意力方法。其核心技術 Kimi Delta Attention(KDA)是對 Gated DeltaNet 的一次優化,特別引入了一種更高效的門控機制,以更好地管理有限狀態 RNN 的記憶使用。

Kimi Linear 的設計由三份 Kimi Delta Attention 和一份全局 MLA 組成。這種結構通過細粒度的門控來壓縮有限狀態 RNN 的記憶,使得模型在處理信息時更加高效。官方指出,在處理1M token 的數據場景中,Kimi Linear 的 KV cache 佔用降低了75%,而解碼吞吐量最高可提升6倍,TPOT 相較於傳統 MLA 加速了6.3倍。

這種新的架構爲各種 AI 應用場景提供了更強的支持,無論是在信息密集型的自然語言處理任務還是在動態環境中的強化學習,Kimi Linear 都有着顯著的優勢。隨着 AI 技術的不斷髮展,這種高效的注意力機制可能會爲未來的智能應用帶來新的突破。

更多技術細節可以在 Kimi Linear 的技術報告中找到,https://github.com/MoonshotAI/Kimi-Linear/blob/master/tech_report.pdf。

劃重點:

🌟 Kimi Linear 是一種新型的混合線性注意力架構,優化了信息處理性能。

🚀 該架構在1M token 場景下,KV cache 佔用減少75%,解碼吞吐量提升6倍。

🔍 Kimi Delta Attention 是其核心技術,通過細粒度門控優化了 RNN 的記憶管理。