近日,螞蟻集團開源了全新的 dInfer 框架,專門用於擴散大語言模型的高效推理。這一框架的推出標誌着擴散模型在自然語言處理領域的應用取得了重大進展,推理速度提升至以往的10倍,並在同樣模型性能下超越了傳統的自迴歸模型。

自迴歸模型長期以來一直是自然語言處理的主流,生成文本的過程類似於一個嚴謹的學生逐字撰寫,因而速度受到限制。而擴散模型則採用 “去噪” 的方式生成文本,像是在處理被噪聲覆蓋的圖片,通過逐步去除噪聲來恢復清晰的圖像。這種模式具有天然的並行優勢,能夠一次預測多個詞語,從而提高效率。

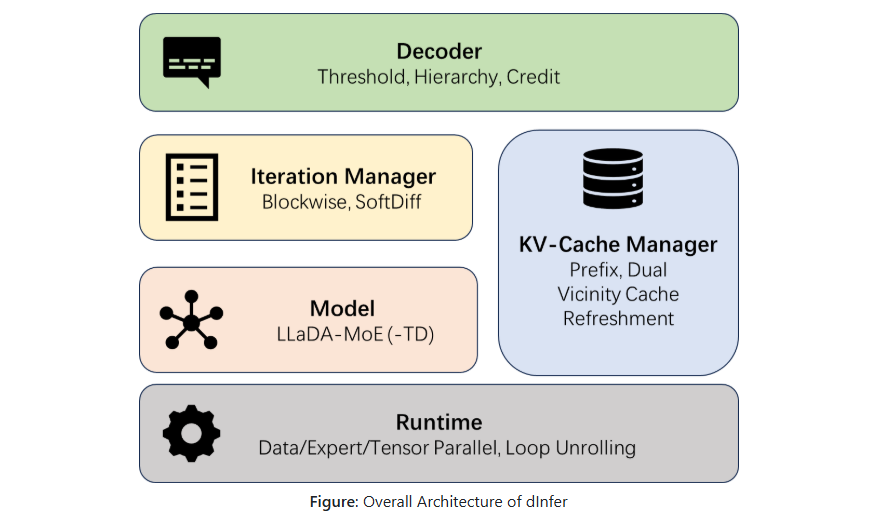

儘管擴散模型理論上具有更高的潛力,但在實際推理中,其速度問題依然顯著。爲了解決這一問題,螞蟻團隊在 dInfer 框架中採用了創新的設計,將推理流程分爲四個模塊,分別爲模型接入、KV 緩存管理、擴散迭代管理和解碼策略。在並行解碼方面,dInfer 通過 “層級解碼” 和 “信用解碼” 兩種新策略有效減少了生成過程中的語義衝突,提高了結果的穩定性。

在 KV 緩存方面,dInfer 提出了 “鄰近 KV 緩存刷新” 策略,該策略只針對最近的上下文進行重新計算,顯著降低了計算開銷。通過這一系列技術創新,dInfer 在性能上表現優異。在與 Fast-dLLM 和 vLLM 框架的比較測試中,dInfer 在多個數據集上展現了卓越的推理速度和吞吐量,關閉 KV 緩存時,平均 TPS 達到了407.36,是 Fast-dLLM 的6.5倍。

dInfer 框架的推出,不僅提升了擴散模型的實用性,也爲自然語言處理領域的未來發展開闢了新的方向。

項目:https://github.com/inclusionAI/dInfer

劃重點:

🌟 dInfer 框架使擴散大語言模型的推理速度提升10倍,超越傳統自迴歸模型。

🚀 採用並行解碼和 KV 緩存管理技術,有效解決了擴散模型的推理速度瓶頸。

📊 實驗數據顯示,dInfer 在推理性能上遠超其他同類框架,顯示出廣泛的應用潛力。