近日,微軟研究院正式開源了其最新音頻模型 ——VibeVoice-1.5B。該模型在語音合成技術上實現了多項重大突破,使得合成的語音更自然、時長更長、效果更優。

VibeVoice-1.5B 具備一次性合成90分鐘超長語音的能力,這在以往的語音合成模型中是罕見的。之前,多數模型只能合成60分鐘以內的語音,且在超過30分鐘時容易出現音色漂移和語義斷裂的問題。此模型還支持最多四位發言人發言,顯著提高了多說話人的合成效果,而以往的開源模型最多隻能支持兩位發言者。此外,VibeVoice 還實現了對24kHz 原始音頻的3200倍壓縮,大大提高了壓縮效率,且保留了高保真的語音效果。

VibeVoice 模型的核心在於其獨特的雙 tokenizer 架構。與傳統 TTS 模型多依賴單一 tokenizer 提取特徵不同,VibeVoice 創新性地引入了聲學 tokenizer 與語義 tokenizer 的協同工作機制,解決了音色與語義不匹配的問題。聲學 tokenizer 專注於保留聲音特徵並實現極致壓縮,而語義 tokenizer 則負責提取與文本語義相一致的特徵,確保合成語音的情感與文本內容一致。

在訓練方面,VibeVoice 採用了課程學習策略,將輸入序列長度逐步增加,從而避免了因處理超長序列而導致的訓練失敗。其訓練過程中的聲學 tokenizer 與語義 tokenizer 參數保持不變,確保了特徵提取模塊的穩定性,進而縮短了訓練週期。

VibeVoice-1.5B 的開源不僅爲語音合成領域帶來了新的技術突破,也爲未來更大參數模型的發佈奠定了基礎。對於音頻處理和語音合成的研究人員和開發者來說,這是一個值得關注的創新進展。

開源地址:https://huggingface.co/microsoft/VibeVoice-1.5B

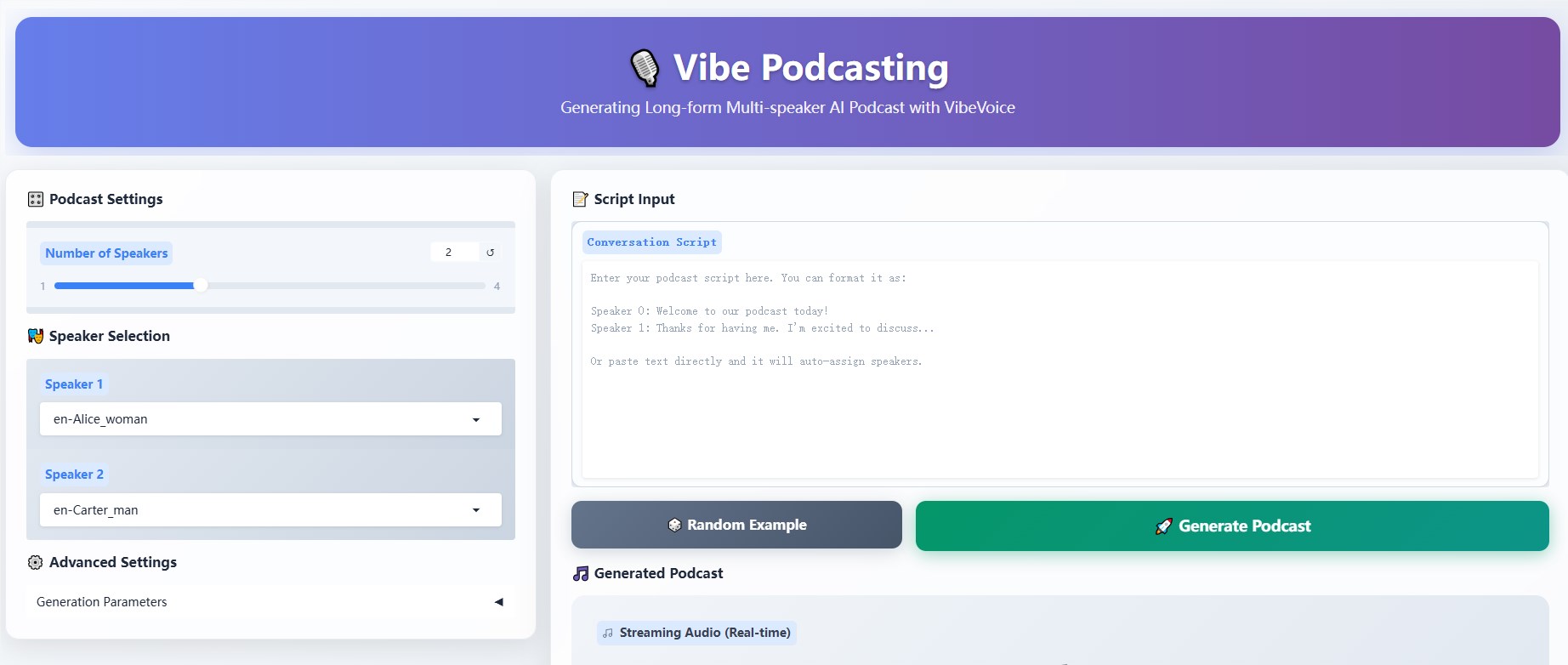

在線demo:https://aka.ms/VibeVoice-Demo

劃重點:

🔊 VibeVoice-1.5B 模型可一次性合成90分鐘的超長語音,支持最多四位發言人。

💾 該模型實現3200倍的音頻壓縮率,保持高保真語音效果。

🤖 採用雙 tokenizer 架構,解決音色與語義不匹配的問題。