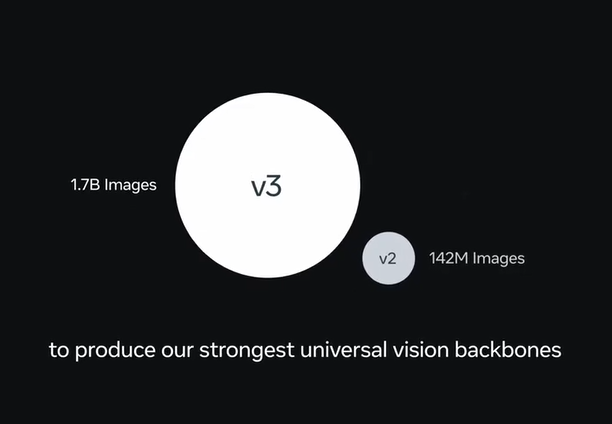

Meta AI於近日正式開源了全新一代通用圖像識別模型DINOv3,引發了全球開發者和研究人員的廣泛關注。這款基於自監督學習的計算機視覺模型,以其無需人工標註即可實現卓越性能的特性,被認爲是AI視覺技術的新里程碑。

自監督學習:無需人工標註的突破

DINOv3的核心創新在於其自監督學習框架,徹底擺脫了對人工標註的依賴。傳統圖像識別模型通常需要大量標註數據進行訓練,而DINOv3通過自監督學習,能夠從海量未標註圖像中自主提取特徵。這一特性不僅降低了數據準備的成本,還使其在數據稀缺或標註昂貴的場景中展現出巨大潛力。社交媒體反饋顯示,DINOv3在多項基準測試中的表現與SigLIP2、Perception Encoder等領先模型持平甚至更優,彰顯了其強大的通用性。

高分辨率特徵提取:全局與細節兼得

DINOv3的另一大亮點是其高質量高分辨率密集特徵表示能力。模型能夠同時捕捉圖像的全局信息和局部細節,爲各種視覺任務提供強大的支持。無論是圖像分類、目標檢測、語義分割,還是圖像檢索和深度估計,DINOv3均表現出色。此外,DINOv3不僅限於處理普通照片,還能高效處理衛星圖像、醫學圖像等多種複雜數據類型,爲跨領域應用奠定了堅實基礎。

廣泛應用場景:從環境監測到醫療安防

DINOv3的通用性和高性能使其在多個行業展現出廣闊的應用前景。以下是一些典型場景:

- 環境監測:DINOv3可用於分析衛星圖像,助力監測森林覆蓋、土地使用變化等,支持環境保護和資源管理。

- 自動駕駛:通過精準的目標檢測和語義分割,DINOv3能夠提升自動駕駛系統對道路環境和物體的識別能力。

- 醫療保健:在醫學圖像分析中,DINOv3可用於檢測病竈、分割器官,提升診斷效率和準確性。

- 安防監控:其人員識別和行爲分析能力,爲智能安防系統提供了強大支持。

社交媒體上已有開發者表示,DINOv3的開源爲中小型企業和研究機構提供了低成本接入尖端AI技術的機會,尤其是在數據資源有限的場景下。

開源賦能:推動AI視覺生態發展

Meta AI此次將DINOv3的完整訓練代碼和預訓練模型以商業友好許可開源,極大降低了開發者的使用門檻。模型支持通過PyTorch Hub和Hugging Face Transformers庫加載,提供了多種規模的預訓練模型(從21M到7B參數),適應不同計算資源的需求。此外,Meta還提供了下游任務的評估代碼和示例筆記本,方便開發者快速上手。社交媒體反饋顯示,DINOv3已被整合進Hugging Face生態,開發者社區對其易用性和性能表現讚不絕口。

DINOv3開啓視覺AI新篇章

DINOv3的發佈不僅是Meta AI在計算機視覺領域的一次技術飛躍,也是開源AI生態的重要推動力。其自監督學習能力和多任務適應性,爲開發者提供了前所未有的靈活性,特別是在數據稀缺的場景下。AIbase認爲,DINOv3的開源將加速AI視覺技術在環境、醫療、自動駕駛等領域的落地,助力構建更加智能化的未來。

然而,社交媒體上也有聲音提醒,DINOv3的廣泛應用可能帶來隱私和偏見等潛在風險,未來需進一步關注其在實際部署中的倫理問題。

結語

DINOv3的開源標誌着自監督學習在計算機視覺領域的又一次突破。從環境監測到醫療診斷,從自動駕駛到安防監控,DINOv3的通用性和高性能正在爲各行各業帶來新的可能性。

項目地址:https://github.com/facebookresearch/dinov3