字節跳動 Seed 團隊正式對外發布其最新研發成果——Seed LiveInterpret2.0端到端同聲傳譯大模型。這一模型的發佈標誌着機器同聲傳譯技術取得了重大突破,其翻譯準確率接近專業同傳譯員水平,且延遲時間極低,僅需3秒,同時還具備實時聲音復刻功能,能夠以說話者的音色輸出翻譯後的語音,極大地提升了跨語言交流的自然度和流暢性。

同聲傳譯一直被視爲翻譯領域的巔峯技能,它要求譯者在極短時間內完成語言轉換,邊聽邊說,對翻譯技術研究者來說極具挑戰性。Seed LiveInterpret2.0的出現,不僅在中英同傳翻譯質量上達到了業界頂尖水平(SOTA),更實現了極低的語音延遲,爲同聲傳譯領域帶來了新的技術標杆。

Seed LiveInterpret2.0基於全雙工端到端語音生成理解框架,支持中英互譯,並可實時處理多人語音輸入,像人類同傳譯員一樣以極低的延遲 “邊聽邊說”,一邊接收源語言語音輸入,一邊直接輸出目標語言的翻譯語音。此外,該模型還支持零樣本聲音復刻,無需提前採集聲音樣本,僅通過實時對話即可合成“原聲”語音翻譯,讓溝通更加流暢自然。

在測試中,Seed LiveInterpret2.0展示了其強大的能力。面對40秒的大段中文表達,該模型能夠低延遲地絲滑輸出同款音色的英語翻譯。不僅如此,它還能快速學習音色,無論是《西遊記》裏的豬八戒,還是《紅樓夢》中的林黛玉,即便此前未“聽”過角色的聲音,依然能通過實時交互進行現場演繹。

相比傳統機器同傳系統,Seed LiveInterpret2.0在多個方面展現出顯著優勢。首先,它具備接近真人同傳的翻譯準確率,精準的語音理解能力保障了翻譯準確度,在多人會議等複雜場景中英雙向翻譯準確率超70%,單人演講翻譯準確率超80%,接近真人專業同傳水平。其次,其極低延遲的 “邊聽邊說” 能力採用全雙工語音理解生成框架,翻譯延遲可低至2-3秒,較傳統機器同傳系統降低超60%,實現了真正的 “邊聽邊說” 翻譯。此外,零樣本聲音復刻功能讓模型能夠以說話人的音色特質實時 “說出” 外語,提升交流的沉浸感和親和力。最後,該模型還能智能平衡翻譯質量、延遲和語音輸出節奏,根據語音清晰度、流暢度、複雜程度,調整輸出節奏,並適配不同語言特性,即使面對超長信息,也能保證傳譯語音節奏的自然流暢。

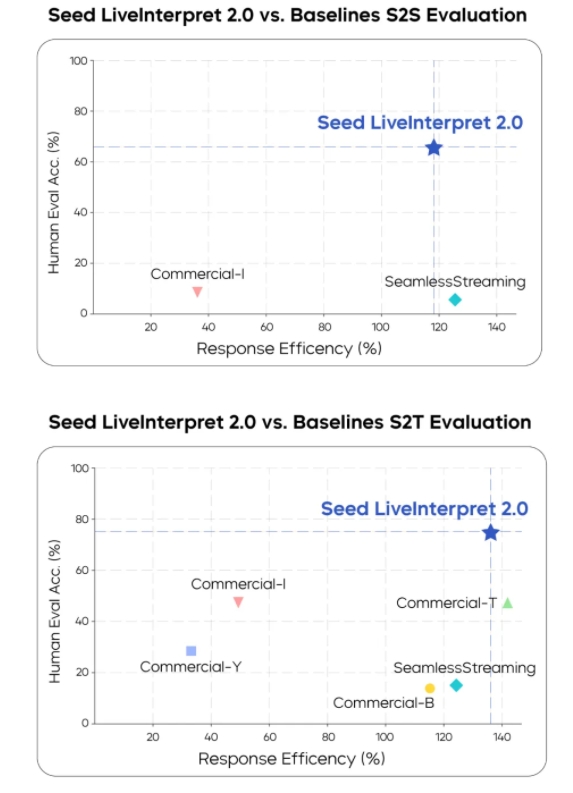

在專業人工評測中,Seed LiveInterpret2.0的表現尤爲突出。評測基於 RealSI 數據集,這是一個包含中英雙向各10個領域的公開測試集。人工評測團隊以傳達有效信息的佔比(Valid Information Proportion)爲指標,在中英方向上測試了包括 Seed LiveInterpret2.0在內的多個業界領先的同傳系統。評測結果顯示,在語音到文本的同傳任務中,Seed LiveInterpret2.0中英互譯平均翻譯質量的人類評分達到74.8(滿分100,評估譯文準確率),較排名第二的基準系統(47.3分)超出58%。在語音到語音中英同傳任務中,僅3個測評的翻譯系統支持該能力,其中 Seed LiveInterpret2.0中英互譯平均翻譯質量達到66.3分(滿分100,除評估譯文準確率,還評估語音輸出時延、語速、發音、流暢性等指標),遠超其他基準系統,達到接近專業真人同傳的水平。同時,大部分基準系統也不支持聲音復刻功能。

在延遲表現上,Seed LiveInterpret2.0在語音到文本場景中,輸出首字平均延遲僅2.21秒,在語音到語音場景中,輸出延時僅2.53秒,做到了對翻譯質量以及時延的均衡。

技術報告:

https://arxiv.org/pdf/2507.17527

項目主頁:

https://seed.bytedance.com/seed_liveinterpret