近日,字節跳動Seed團隊攜手香港大學與復旦大學,共同推出了創新的強化學習訓練方法——POLARIS。該方法通過精心設計的Scaling RL策略,成功將小模型的數學推理能力提升至與超大模型相媲美的水平,爲人工智能領域的小模型優化提供了新路徑。

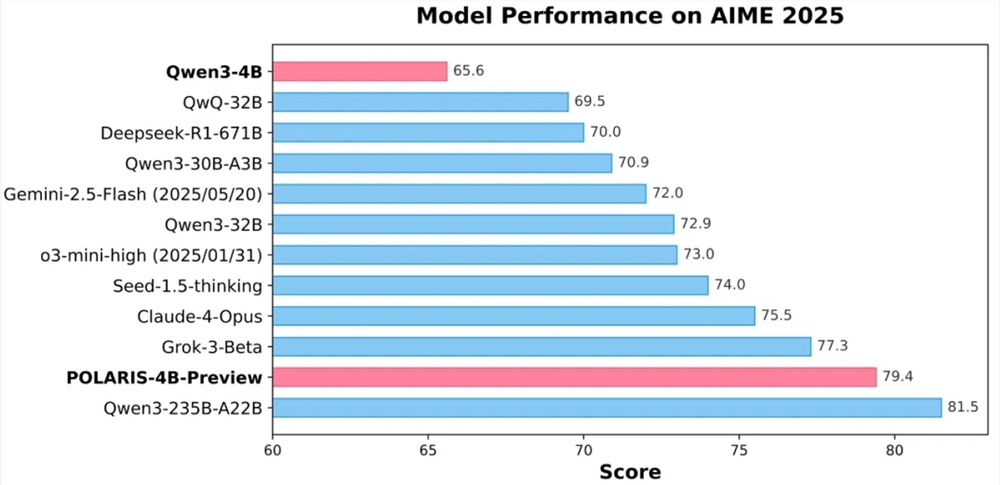

實驗結果顯示,採用POLARIS訓練的40億參數開源模型Qwen3-4B,在AIME25和AIME24數學測試中分別取得了79.4%和81.2%的高準確率,性能超越部分更大規模的閉源模型。尤爲突出的是,POLARIS-4B模型的輕量化設計,使其能夠在消費級顯卡上輕鬆部署,大大降低了應用門檻。

POLARIS的核心創新在於其訓練策略。研究團隊發現,通過圍繞待訓練模型定製訓練數據和超參數設置,可以顯著提升小模型的數學推理能力。具體實踐中,團隊動態調整了訓練數據的難度分佈,構建了輕微偏向難題的數據集,以避免樣本難度過於集中。同時,引入數據動態更新策略,根據模型在訓練過程中的表現實時剔除過易樣本,確保訓練的有效性。

在採樣控制方面,POLARIS通過精細調控採樣溫度,平衡了模型性能與生成路徑的多樣性。研究發現,採樣溫度對模型性能和路徑多樣性具有顯著影響,過高或過低的溫度均不利於模型訓練。因此,團隊提出了控制探索區的溫度初始化方法,並在訓練過程中動態調整採樣溫度,以保持生成內容的多樣性。

針對長上下文訓練的挑戰,POLARIS引入了長度外推技術,通過位置編碼RoPE的調整,使模型能夠處理超出訓練時所見的更長序列。這一創新策略有效補償了長文本訓練中的不足,提升了模型在長文本生成任務上的性能。

此外,POLARIS還採用了多階段RL訓練方法,早期使用較短的上下文窗口進行訓練,待模型表現收斂後再逐漸增加上下文窗口長度。這一策略有助於模型逐步適應更復雜的推理任務,提升了訓練的穩定性和效果。

目前,POLARIS的詳細訓練方法、訓練數據、訓練代碼和實驗模型已全部開源。研究團隊在多個主流推理評測集上驗證了POLARIS的有效性,結果顯示,不同規模的模型以及不同的模型家族在應用POLARIS訓練方法後,模型效果均有顯著提升。

GitHub 主頁:

https://github.com/ChenxinAn-fdu/POLARIS

Hugging Face 主頁:

https://huggingface.co/POLARIS-Project