近日,騰訊雲官網正式上線了騰訊混元A13B模型的API服務,輸入價格定爲每百萬Tokens0.5元,輸出價格則爲每百萬Tokens2元,這一舉措迅速在開發者社區中引發了熱烈反響。

作爲業界首個13B級別的MoE(混合專家)開源混合推理模型,Hunyuan-A13B以其總參數80B、激活參數僅13B的精簡設計,實現了與同等架構領先開源模型相媲美的效果,同時在推理速度上更勝一籌,性價比顯著提升。這一創新不僅降低了開發者獲取先進模型能力的門檻,更爲AI應用的廣泛普及奠定了堅實基礎。

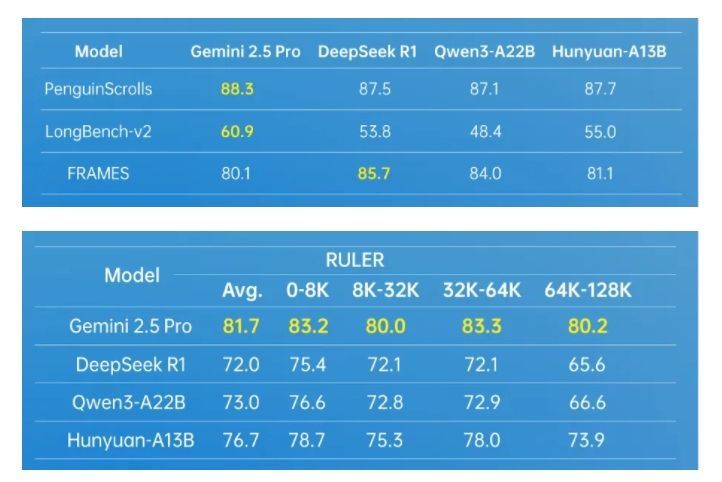

Hunyuan-A13B模型依託先進的架構設計,展現出了強大的通用能力。在多個業內權威數據測試集上,該模型均取得了優異成績,尤其在Agent工具調用和長文處理方面表現突出。爲了進一步提升Agent能力,騰訊混元團隊還構建了一套多Agent數據合成框架,通過接入MCP、沙箱、大語言模型模擬等多樣環境,並利用強化學習技術,讓Agent在多種環境中自主探索與學習,從而顯著提升了模型的實用性和效果。

在長文處理方面,Hunyuan-A13B支持256K原生上下文窗口,能夠在多個長文數據集中保持優異表現。此外,該模型還創新性地引入了融合推理模式,允許用戶根據任務需求在快思考和慢思考模式間自由切換,既保證了輸出效率,又兼顧了特定任務的準確性,實現了計算資源的優化分配。

對於個人開發者而言,Hunyuan-A13B模型同樣具有極高的友好度。在嚴格條件下,僅需1張中低端GPU卡即可完成部署。目前,該模型已無縫融入開源主流推理框架生態,支持多種量化格式,且在相同輸入輸出規模上,整體吞吐量是前沿開源模型的2倍以上,展現了其卓越的性能和靈活性。

Hunyuan-A13B模型的成功,離不開騰訊混元團隊在模型預訓練和後訓練環節的創新技術。預訓練階段,團隊訓練了高達20T tokens的語料庫,覆蓋了多個領域,顯著提升了模型的通用能力。同時,通過系統性分析和建模驗證,團隊還構建了適用於MoE架構的Scaling Law聯合公式,爲MoE架構設計提供了可量化的工程化指導。後訓練階段,則採用了多階段訓練方式,進一步提升了模型的推理能力和通用性。

作爲騰訊內部應用和調用量最大的大語言模型之一,Hunyuan-A13B已廣泛應用於400多個業務場景,日均請求量超過1.3億次,充分證明了其在實際應用中的價值和穩定性。

https://cloud.tencent.com/product/tclm