騰訊近日宣佈開源其全新語言模型“**混元-A13B**”,該模型引入了創新的**動態推理方法**,使其能夠根據任務複雜性在快速和深度“思考”之間智能切換。

核心亮點:動態推理與MoE架構

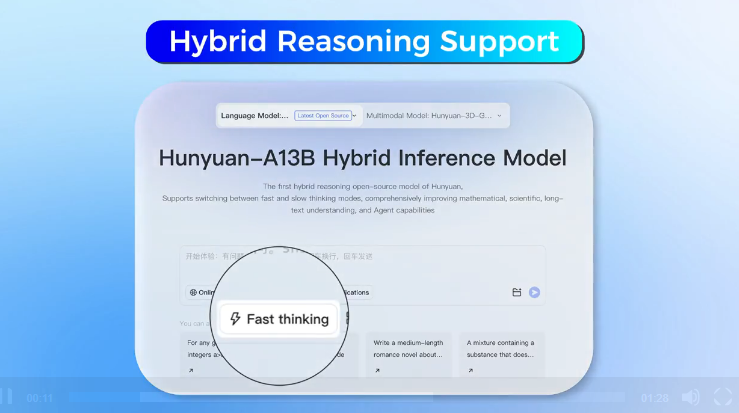

“混元-A13B”的核心優勢在於其**實時調整推理深度**的能力。對於簡單的查詢,模型會啓用**快速模式**,以最少的推理步驟迅速響應;而面對更復雜的問題,它則能激活涉及**多步驟思考的深度推理過程**。用戶還可以通過特定命令來手動控制這種行爲,使用“**/think**”啓用深度模式,或使用“**/no_think**”關閉深度模式。

該模型採用了**混合專家(MoE)架構**,總參數量高達**800億**,但在實際推理過程中,僅有**130億個參數**處於活躍狀態,這有助於提高運行效率。此外,“混元-A13B”支持最高達**256,000個標記的上下文窗口**,處理長文本的能力顯著增強。

訓練數據與性能表現

根據騰訊發佈的技術報告,“混元-A13B”已在**20萬億個token**上進行訓練,並針對推理任務及更廣泛的用例進行了優化。爲了提升模型在科學任務中的可靠性,騰訊特別從**STEM(科學、技術、工程、數學)領域**收集了**2500億個token**進行訓練,數據涵蓋數學教科書、考試、GitHub開源代碼、邏輯謎題以及從中**學到大學的科學文本**。

騰訊聲稱,其“**混元-A13B-Instruct**”版本能夠與OpenAI、Deepseek和阿里巴巴Qwen等領先模型相媲美。報告指出,在**2024年美國數學競賽AIME**中,“混元-A13B”的準確率達到了**87.3%**,領先於OpenAI o1的74.3%。

然而,需要注意的是,從**2025年的結果來看**,OpenAI o1在該輪測試中領先近3%。此外,騰訊的比較數據基於Deepseek-R1的**過時1月版本**,而Deepseek在**5月發佈的版本**在AIME2024和2025中的表現更優異,分別取得了91.4分和87.5分。