近日,來自中國人民大學、上海人工智能實驗室、倫敦大學學院和大連理工大學的研究團隊揭示了大模型推理過程中的一個重要發現:當模型在思考時,所使用的 “思考詞” 實際上反映了其內部信息量的顯著提升。這一研究成果通過信息論的方法,爲我們更好地理解人工智能的推理機制提供了新的視角。

論文地址:https://arxiv.org/abs/2506.02867

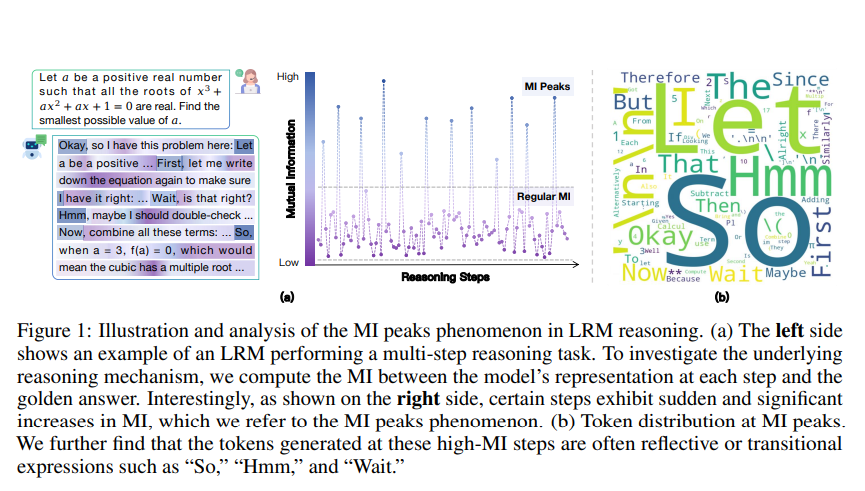

你或許見過大模型在解答問題時,會輸出一些看似人類化的語言,比如 “嗯……”、“讓我想想……” 或 “因此……”。這些 “思考詞” 是簡單的表面裝飾,還是代表着模型真正的思考過程?這個問題困擾着許多研究者。如今的研究表明,這些詞彙並非僅僅是爲了模仿人類,而是關鍵的 “信息高峯”,顯示出模型在特定時刻的思維狀態。

圖源備註:圖片由AI生成,圖片授權服務商Midjourney

研究團隊對多種大模型進行追蹤觀察,測量它們在推理過程中的互信息變化。結果發現,模型在某些時刻的互信息值會急劇上升,形成明顯的 “互信息峯值”。這意味着,在這些關鍵時刻,模型內部包含了指向正確答案的關鍵信息。這一現象在經過推理強化訓練的模型中表現得尤爲明顯,而非推理模型則顯得較爲平淡。

更爲有趣的是,當研究人員將這些互信息高峯時刻的表徵轉化爲人類可理解的語言時,發現這些時刻正好對應了那些頻繁出現的 “思考詞”。例如,在進行復雜推理時,模型往往會輸出 “讓我想想”、“所以我必須……” 等表述。這些 “思考詞” 不再是可有可無的點綴,而是模型推理過程中的關鍵路標,推動着其思考的進展。

基於這一發現,研究者們提出了兩種無需額外訓練就能提升大模型推理能力的方法。這意味着,未來的 AI 可以在保留現有知識的基礎上,通過合理利用這些信息高峯,顯著提升其推理性能。這一研究不僅推動了大模型的理論研究,也爲實際應用提供了新的思路。