2025年7月4日,崑崙萬維乘勢而上,繼續開源第二代獎勵模型Skywork-Reward-V2系列。此係列共包含8個基於不同基座模型、參數規模從6億到80億不等的獎勵模型,一經推出便在七大主流獎勵模型評測榜單中全面奪魁,成爲開源獎勵模型領域的焦點。

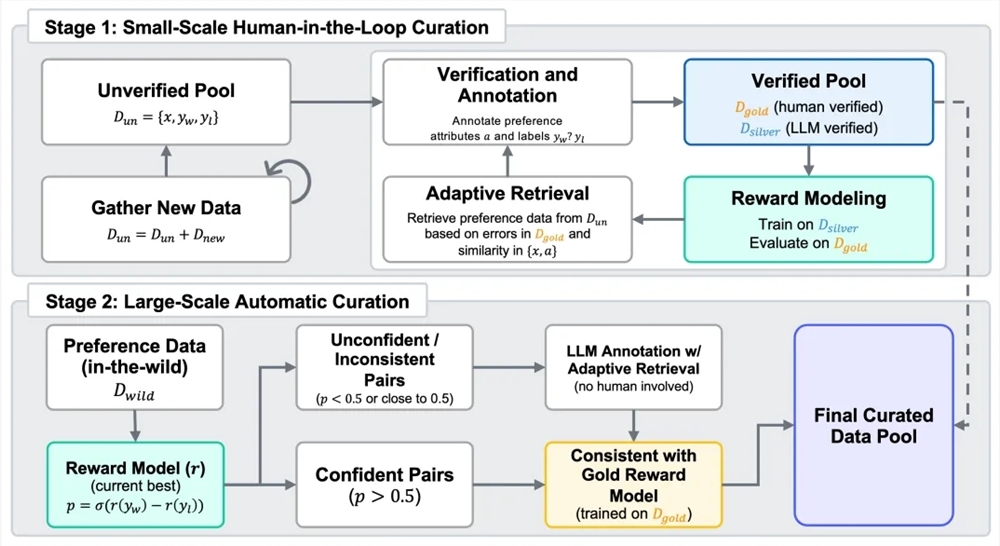

獎勵模型在從人類反饋中強化學習(RLHF)過程中起着關鍵作用。爲打造新一代獎勵模型,崑崙萬維構建了包含4000萬對偏好對比的混合數據集Skywork-SynPref-40M。在數據處理上,團隊採用人機協同的兩階段流程,將人工標註的高質量與模型的規模化處理能力相結合。第一階段,先構建未經驗證的初始偏好池,藉助大語言模型生成輔助屬性,人工標註者再依照嚴格協議和外部工具、大語言模型對部分數據精細審覈,構建出小規模高質量“金標準”數據集。隨後以金標準數據偏好標籤爲引導,結合大語言模型大規模生成高質量“銀標準”數據,並多輪迭代優化。第二階段則轉向自動化大規模數據擴展,用訓練完成的獎勵模型執行一致性過濾,減少人工標註負擔的同時,實現偏好數據規模與質量的平衡。

基於優質混合偏好數據開發的Skywork-Reward-V2系列,展現出廣泛適用性和出色能力。它涵蓋對人類偏好的通用對齊、客觀正確性、安全性、風格偏差抵抗能力以及best-of-N擴展能力等多個維度。在Reward Bench v1/v2、PPE Preference & Correctness、RMB、RM-Bench、JudgeBench等七個主流獎勵模型評估基準上全面達到當前最優(SOTA)水平。即便基於最小模型Skywork-Reward-V2-Qwen3-0.6B,整體性能也幾乎達到上一代最強模型的平均水平,Skywork-Reward-V2-Qwen3-1.7B更是超越當前開源獎勵模型的SOTA。最大規模的Skywork-Reward-V2-Llama-3.1-8B在所有主流基準測試中全面超越,成爲當前整體表現最優的開源獎勵模型。

該系列模型還具備廣泛覆蓋多維人類偏好能力。在通用偏好評估基準上優於多個參數更大的模型及最新生成型獎勵模型;在客觀正確性評估方面,知識密集型任務表現突出;在多項高級能力評估中,包括Best-of-N任務、偏見抵抗能力測試、複雜指令理解及真實性判斷等均取得領先成績,展現出出色的泛化能力與實用性。

此外,數據篩選流程的高度擴展性顯著提升了獎勵模型性能。經過精細篩選和過濾的偏好數據,在多輪迭代訓練中能持續有效提升模型整體性能,尤其在第二階段全自動數據擴展中表現顯著。早期版本實驗顯示,僅用1.8%的高質量數據訓練8B規模模型,性能就超過當前70B級SOTA獎勵模型,印證了Skywork-SynPref數據集在規模和質量上的優勢。

HuggingFace地址:

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHub地址:

https://github.com/SkyworkAI/Skywork-Reward-V2