Bilibili(B站)宣佈其開源動漫視頻生成模型AniSora迎來重大更新,正式發佈AniSora V3。作爲Index-AniSora項目的一部分,V3版本在原有基礎上進一步優化了生成質量、動作流暢度和風格多樣性,爲動漫、漫畫及VTuber內容創作者提供了更強大的工具。AIbase深入解讀AniSora V3的技術突破、應用場景及行業影響。

技術升級:更高質量與精準控制

AniSora V3基於Bilibili此前開源的CogVideoX-5B和Wan2.1-14B模型,結合強化學習與人類反饋(RLHF)框架,顯著提升了生成視頻的視覺質量和動作一致性。其支持一鍵生成多種風格的動漫視頻鏡頭,包括番劇片段、國創動畫、漫畫視頻改編、VTuber內容)等

核心升級包括:

- 時空掩碼模塊(Spatiotemporal Mask Module)優化:V3版本增強了時空控制能力,支持更復雜的動畫任務,如精細的角色表情控制、動態鏡頭移動和局部圖像引導生成。例如,提示“五位女孩在鏡頭放大時起舞,左手上舉至頭頂再下放至膝蓋”能生成流暢的舞蹈動畫,鏡頭與角色動作同步自然。

- 數據集擴展:V3繼續依託超過1000萬高質量動漫視頻片段(從100萬原始視頻中提取)進行訓練,新增數據清洗流水線,確保生成內容的風格一致性和細節豐富度。

- 硬件優化:V3新增對華爲Ascend910B NPU的原生支持,完全基於國產芯片訓練,推理速度提升約20%,生成4秒高清視頻僅需2-3分鐘。

- 多任務學習:V3強化了多任務處理能力,支持從單幀圖像生成視頻、關鍵幀插值到脣部同步等功能,特別適合漫畫改編和VTuber內容創作。

在最新基準測試中,AniSora V3在VBench和雙盲主觀測試中,角色一致性和動作流暢度均達到業界頂尖水平(SOTA),尤其在複雜動作(如違反物理規律的誇張動漫動作)上表現突出。

開源生態:社區驅動與透明發展

AniSora V3的完整訓練和推理代碼已於2025年7月2日在GitHub上更新,開發者可通過Hugging Face訪問模型權重及948個動畫視頻的評估數據集。 Bilibili強調,AniSora是“對動漫世界的開源禮物”,鼓勵社區協作優化模型。用戶需填寫申請表併發送至指定郵箱(如yangsiqian@bilibili.com)以獲取V2.0權重和完整數據集訪問權限。

V3還引入了首個針對動漫視頻生成的RLHF框架,通過AnimeReward和GAPO等工具對模型進行微調,確保輸出更符合人類審美和動漫風格需求。社區開發者已開始基於V3開發定製化插件,例如增強特定動漫風格(如吉卜力風)的生成效果。

應用場景:從創意到商業

AniSora V3支持多種動漫風格,包括日本動漫、國產原創動畫、漫畫改編、VTuber內容及惡搞動畫(鬼畜動畫),覆蓋90%的動漫視頻應用場景。 具體應用包括:

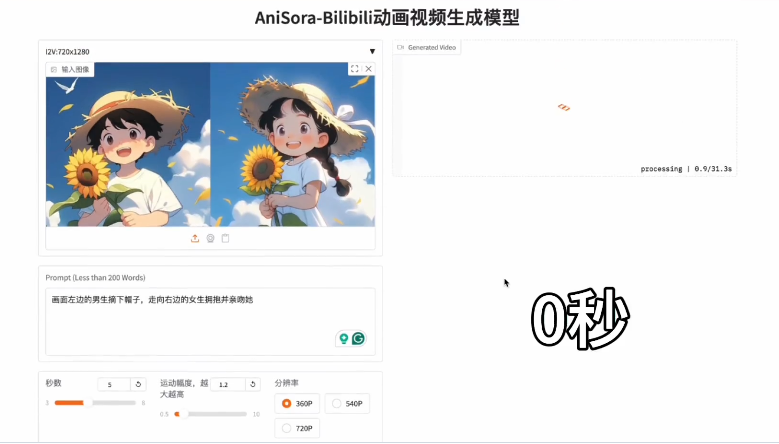

- 單圖轉視頻:用戶上傳一張高質量動漫圖像,配合文本提示(如“角色在向前行駛的車中揮手,頭髮隨風擺動”),即可生成動態視頻,保持角色細節和風格一致。

- 漫畫改編:從漫畫幀生成帶脣部同步和動作的動畫,適合快速製作預告片或短篇動畫。

- VTuber與遊戲:支持實時生成角色動畫,助力獨立創作者和遊戲開發者快速測試角色動作。

- 高分辨率輸出:生成視頻支持高達1080p,確保在社交媒體、流媒體平臺上的專業呈現。

AIbase測試顯示,V3在生成複雜場景(如多角色交互、動態背景)時,相比V2減少了約15%的僞影問題,生成時間縮短至平均2.5分鐘(4秒視頻)。

AniSora V3的發佈進一步降低了動漫創作門檻,使獨立創作者和小型團隊能以低成本實現高質量動畫製作。相比OpenAI的Sora或Kling等通用視頻生成模型,AniSora V3專注於動漫領域,填補了市場空白。 與字節跳動的EX-4D相比,AniSora V3更專注於2D/2.5D動漫風格,而非4D多視角生成,展現了不同的技術路線。

項目:https://t.co/I3HPKPvsBV