谷歌於本週五凌晨正式發佈並開源全新端側多模態大模型Gemma3n,這一突破性產品爲手機、平板、筆記本等端側設備帶來了此前只能在雲端體驗的強大多模態功能。

核心特性:小體積大能力

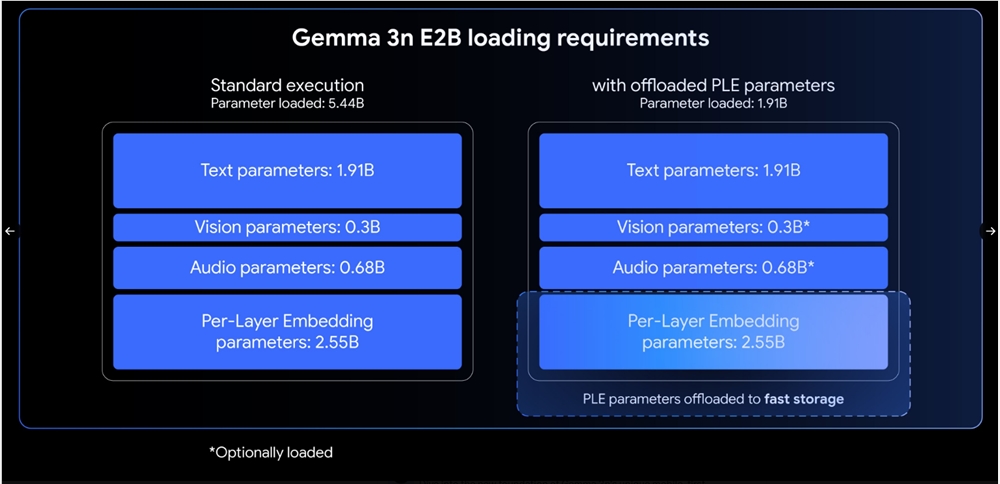

Gemma3n提供E2B和E4B兩個版本,雖然原始參數量分別爲5B和8B,但通過架構創新,其內存佔用僅相當於傳統2B和4B模型,分別只需2GB和3GB內存即可運行。該模型原生支持圖像、音頻、視頻和文本的多模態輸入處理,支持140種文本語言和35種語言的多模態理解。

值得一提的是,E4B版本在LMArena評測中得分超過1300,成爲首個達到此基準的100億參數以下模型,在多語言、數學、編碼和推理能力方面均實現顯著提升。

技術創新:四大突破性架構

MatFormer架構:Gemma3n採用全新的Matryoshka Transformer架構,如俄羅斯套娃般實現一個模型包含多種尺寸。訓練E4B模型時同步優化E2B子模型,爲開發者提供靈活的性能選擇。通過Mix-n-Match技術,用戶可在E2B和E4B之間創建自定義尺寸模型。

每層嵌入(PLE)技術:這項創新允許大部分參數在CPU上加載計算,只有核心Transformer權重需要存儲在加速器內存中,大幅提高內存效率的同時不影響模型質量。

KV Cache共享:針對長內容處理優化,通過鍵值緩存共享技術,預填充性能相比Gemma34B提升兩倍,顯著加快長序列處理的首個token生成時間。

先進編碼器:音頻方面採用基於通用語音模型(USM)的編碼器,支持自動語音識別和語音翻譯功能,可處理長達30秒的音頻片段。視覺方面配備MobileNet-V5-300M編碼器,支持多種輸入分辨率,在Google Pixel上可達到每秒60幀的處理速度。

實用功能與應用場景

Gemma3n在語音翻譯方面表現突出,特別是英語與西班牙語、法語、意大利語、葡萄牙語之間的轉換。視覺編碼器MobileNet-V5通過先進蒸餾技術,相比基線模型實現13倍加速,參數減少46%,內存佔用降低4倍,同時保持更高準確率。

開源生態與發展前景

谷歌已在Hugging Face平臺開源模型和權重,並提供詳細文檔和開發指南。自去年首個Gemma模型發佈以來,該系列累計下載量已超過1.6億次,顯示出強勁的開發者生態。

Gemma3n的發佈標誌着端側AI進入新的發展階段,將雲端級別的多模態能力下沉到用戶設備,爲移動應用、智能硬件等領域帶來無限可能。

地址:https://huggingface.co/collections/google/gemma-3n-685065323f5984ef315c93f4

文檔:https://ai.google.dev/gemma/docs/gemma-3n