備受矚目的中國人工智能研究實驗室DeepSeek AI,繼其強大的開源語言模型DeepSeek-R1之後,再次在大型語言模型(LLM)領域取得重大突破。近日,DeepSeek AI正式推出一項名爲自主演原則的批判調優(Self-Principled Critique Tuning,簡稱SPCT)的創新技術,旨在構建更通用、更具擴展性的AI獎勵模型(Reward Models,簡稱RMs)。這項技術有望顯著提升AI在開放式任務和複雜環境中的理解和應對能力,爲更智能的AI應用鋪平道路。

背景:獎勵模型——強化學習的“指路明燈”

在開發先進的LLM的過程中,強化學習(Reinforcement Learning,簡稱RL)已成爲一項關鍵技術。RL通過引入反饋信號來指導模型的微調,使其能夠生成更高質量的回覆。而在這個過程中,獎勵模型扮演着至關重要的角色,如同一個“裁判”,負責評估LLM的輸出並給出相應的分數或“獎勵”。這些獎勵信號能夠有效地引導RL過程,促使LLM學習產生更有用的內容。

然而,當前的獎勵模型也面臨着諸多限制。它們往往在規則明確或答案易於驗證的狹窄領域表現出色,例如DeepSeek-R1等模型在數學和編程問題上的優秀表現就得益於在此類問題上明確的“正確答案”。但是,對於複雜、開放或主觀性較強的一般領域查詢,構建一個有效的獎勵模型仍然是一個巨大的挑戰。DeepSeek AI的研究人員在其論文中指出:“通用獎勵模型需要在特定領域之外生成高質量的獎勵,而這些領域的獎勵標準更加多樣和複雜,並且往往沒有明確的參考或標準答案。”

SPCT:應對四大挑戰,打造通用獎勵模型

爲了克服現有獎勵模型的侷限性,DeepSeek AI的研究人員提出了SPCT這一全新的技術。他們強調了構建通用獎勵模型需要應對的四個關鍵挑戰:

- 輸入靈活性(Input flexibility): 獎勵模型必須能夠處理各種不同的輸入類型,並能夠同時評估一個或多個回覆。

- 準確性(Accuracy): 在標準複雜且缺乏明確答案的各種領域中,獎勵模型必須能夠生成準確的獎勵信號。

- 推理時可擴展性(Inference-time scalability): 當分配更多的計算資源進行推理時,獎勵模型應該能夠產生更高質量的獎勵。

- 學習可擴展的行爲(Learning scalable behaviors): 爲了使獎勵模型在推理時能夠有效地擴展,它們需要學習能夠隨着計算資源的增加而提高性能的行爲。

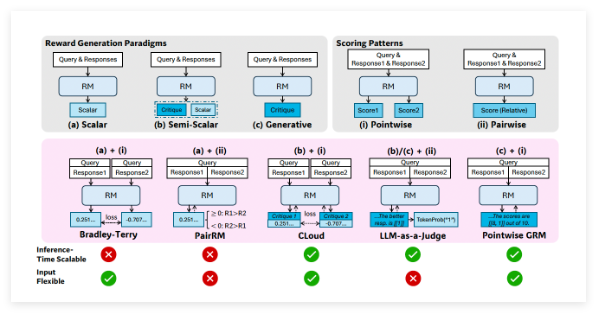

研究人員指出,“基於點的生成式獎勵建模”(Pointwise Generative Reward Modeling,GRM),即模型生成文本評論並從中導出分數的方法,能夠爲通用任務提供所需的靈活性和可擴展性。DeepSeek 團隊在 GPT-4o 和 Gemma-2-27B 等模型上進行的初步實驗表明,“某些原則可以指導生成式獎勵模型在適當的標準內生成獎勵,從而提高獎勵的質量”,這啓發了他們可以通過擴展高質量原則和準確評論的生成來實現獎勵模型的推理時可擴展性。

SPCT的核心機制:自主演原則與批判調優

基於以上發現,DeepSeek 團隊開發了SPCT技術,該技術訓練GRM根據查詢和回覆動態地生成原則和評論。研究人員認爲,原則應該是“獎勵生成的一部分,而不是一個預處理步驟”。通過這種方式,GRM可以根據其正在評估的任務即時生成原則,然後基於這些原則生成批判性意見。

SPCT包含兩個主要階段:

- 拒絕式微調(Rejective fine-tuning): 此階段訓練GRM使用正確的格式爲各種輸入類型生成原則和評論。模型爲給定的查詢/回覆生成原則、評論和獎勵。只有當預測的獎勵與真實情況(例如,正確識別出更好的回覆)一致時,生成的軌跡纔會被接受,否則將被拒絕。這個過程會重複進行,模型在過濾後的示例上進行微調,以提高其原則/評論生成能力。

- 基於規則的強化學習(Rule-based RL): 在此階段,模型通過基於結果的強化學習進行進一步的微調。GRM爲每個查詢生成原則和評論,獎勵信號基於簡單的準確性規則計算(例如,是否選擇了已知的最佳回覆)。然後更新模型,鼓勵GRM學習如何動態且可擴展地生成有效的原則和準確的評論。

爲了應對推理時可擴展性的挑戰,研究人員對同一輸入多次運行GRM,生成不同的原則和評論集。最終的獎勵通過投票(聚合樣本分數)確定。這使得模型能夠考慮更廣泛的視角,從而在獲得更多資源時產生更準確和細緻的最終判斷。

此外,爲了解決一些生成的原則/評論可能質量不高或存在偏差的問題,研究人員引入了一個“元獎勵模型”(meta RM)——一個單獨的、輕量級的標量RM,專門用於預測主要GRM生成的原則/評論是否可能導致正確的最終獎勵。在推理過程中,元RM評估生成的樣本並過濾掉低質量的判斷,進一步提高了擴展性能。

DeepSeek-GRM的卓越表現

研究人員將SPCT應用於谷歌的開源模型Gemma-2-27B,創建了DeepSeek-GRM-27B。在多個基準測試中,他們將其與幾種強大的基線RM(包括LLM-as-a-Judge、標量RM和半標量RM)以及公開模型(如GPT-4o和Nemotron-4-340B-Reward)進行了評估。結果表明,DeepSeek-GRM-27B優於在相同數據上訓練的基線方法。

與標準微調相比,SPCT顯著提高了獎勵的質量,更重要的是,提升了推理時的可擴展性。通過生成更多樣本進行推理時擴展,DeepSeek-GRM-27B的性能大幅提升,甚至超過了更大的模型,如Nemotron-4-340B-Reward和GPT-4o。元RM的引入進一步提升了擴展性,通過過濾判斷實現了最佳結果。研究人員指出:“通過更大規模的採樣,DeepSeek-GRM可以根據更多樣化的原則做出更準確的判斷,並輸出更精細的獎勵。”有趣的是,與在可驗證任務上表現良好但在其他方面表現較差的標量RM相比,SPCT在不同領域表現出更少的偏差。

更通用和可擴展的獎勵模型的開發對於企業級AI應用具有廣闊的前景。潛在的受益領域包括創意任務以及模型必須適應動態環境(如不斷變化的客戶偏好)的應用。

儘管取得了顯著的成果,但與非生成式RM相比,DeepSeek-GRM在純粹可驗證的任務上的性能以及效率方面仍然存在挑戰。DeepSeek 團隊表示,未來的工作將側重於提高效率和更深入的集成。他們總結道:“未來的方向可能包括將GRM集成到在線RL流程中,作爲獎勵系統的通用接口,探索與策略模型進行推理時協同擴展,或者作爲基礎模型的魯棒離線評估器。”

論文:https://arxiv.org/abs/2504.02495