近日,中國科學院自動化研究所與中科紫東太初團隊聯手推出了一種新方法 ——Vision-R1,利用類 R1強化學習技術,顯著提升了視覺定位的能力。這個方法不僅在目標檢測和視覺定位等複雜任務上實現了50% 的性能提升,甚至超過了參數規模超過10倍的現有最優模型(SOTA)。

當前,圖文大模型通常依賴 “預訓練 + 監督微調” 的方法來提高對用戶指令的響應能力,但這種方法在資源消耗和訓練效率上都存在較大挑戰。Vision-R1通過結合高質量的指令對齊數據和強化學習,創新性地改變了這一局面。該方法通過設計一種視覺任務評估驅動的獎勵機制,爲模型的目標定位能力提供了強有力的支持。

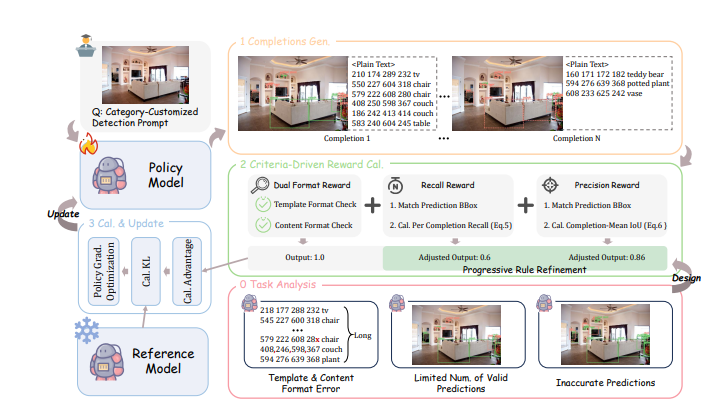

具體而言,Vision-R1的獎勵機制包括四個核心部分:首先,它採用了多目標預測的方式,以確保在密集場景中有效評估預測質量;其次,設計了雙重格式獎勵,以解決長序列預測中的格式錯誤問題;再者,召回獎勵鼓勵模型儘可能多地識別目標;最後,精度獎勵則確保模型生成的目標框質量更高。這些設計相互作用,形成了 “1+1>2” 的優化效果,使模型在複雜視覺任務中表現更爲出色。

爲了解決預測高質量目標框的挑戰,研究團隊還提出了一種漸進式規則調整策略,通過動態調整獎勵計算規則,促使模型持續改進其性能。訓練過程分爲初學階段和進階階段,逐步提高獎勵標準,以實現從基礎到高精度的轉變。

在一系列測試中,Vision-R1在經典目標檢測數據集 COCO 和多樣場景的 ODINW-13上顯示出卓越的性能,無論是基礎性能如何,經過 Vision-R1訓練後,模型的表現都大幅提升,進一步接近專業定位模型。這一方法不僅有效提升了圖文大模型的視覺定位能力,同時也爲未來的多模態 AI 應用提供了新的方向。

項目地址:https://github.com/jefferyZhan/Griffon/tree/master/Vision-R1