話說在計算機科學領域,將那些結構複雜的文檔變成規整的數據,一直是個讓人頭疼的“老大難”問題。以前的“土辦法”,要麼是各種模型“組團出道”,搞出一套複雜的流程,要麼就得祭出“巨無霸”級別的多模態模型,雖然看起來很厲害,但動不動就“幻覺”,還特別“燒錢”。

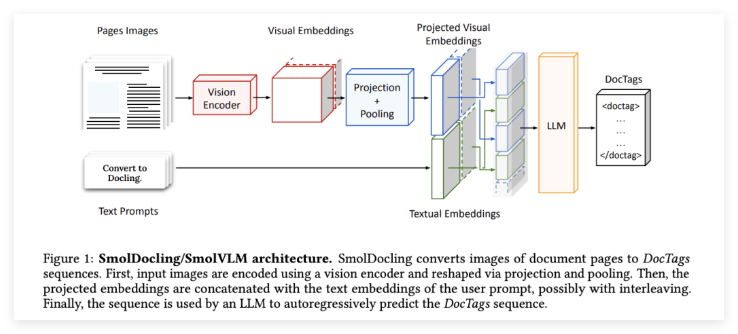

不過最近由IBM和Hugging Face聯手推出的SmolDocling,只有256M參數的開源視覺-語言模型(VLM),目標非常明確,就是要端到端地解決多模態文檔轉換的任務。

SmolDocling的獨門祕籍

SmolDocling最讓人稱道的地方,就是它的“小巧玲瓏”和“一身絕技”。與那些動輒幾十億、幾百億參數的“大模型”不同,SmolDocling僅僅256兆的體量,簡直是模型界的“輕騎兵”,顯著降低了計算複雜性和資源需求。更厲害的是,它能夠通過單個模型處理整個頁面,這一下就把傳統方法中複雜的處理流程給簡化了。

當然,“個子小”並不代表實力弱。SmolDocling還擁有一項“獨門武器”——DocTags,這是一種通用的標記格式,能夠以高度緊湊和清晰的方式精確捕捉頁面元素、它們的結構和空間上下文。你可以把它想象成給文檔裏的每個元素都貼上了清晰的“標籤”,讓機器能夠準確理解文檔的內在邏輯。

SmolDocling的架構基於Hugging Face的SmolVLM-256M,通過優化的tokenization和激進的視覺特徵壓縮方法,實現了計算複雜性的顯著降低。它的核心優勢在於創新的DocTags格式,能夠清晰地分離文檔佈局、文本內容以及表格、公式、代碼片段和圖表等視覺信息。爲了更高效地訓練,SmolDocling還採用了課程學習的方法,先“凍結”視覺編碼器,然後逐步使用更豐富的數據集進行微調,以增強不同文檔元素之間的視覺語義對齊。更令人驚喜的是,得益於其高效性,SmolDocling處理整個文檔頁面的速度非常快,在消費級GPU上平均每頁僅需0.35秒,且僅消耗不到500MB的顯存。

“小模型也能打敗“巨無霸”

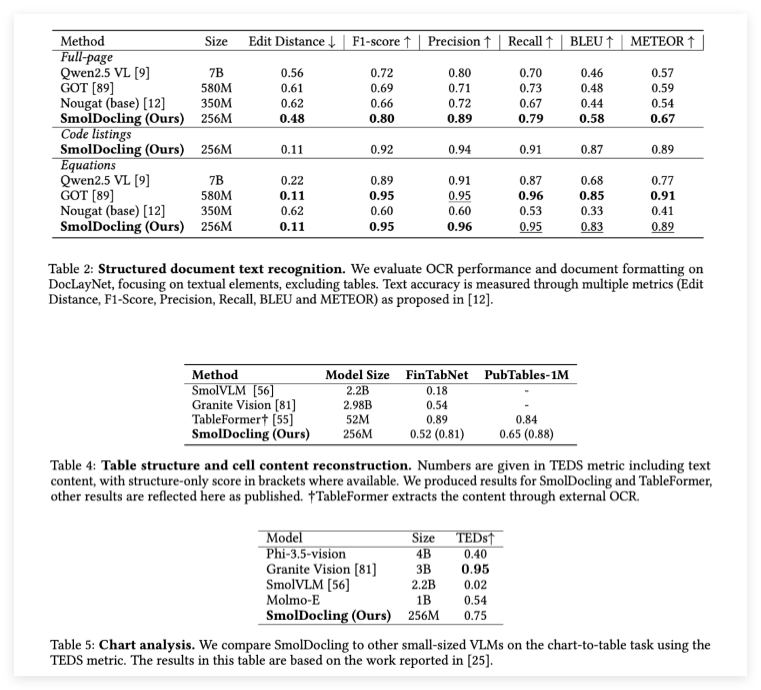

事實勝於雄辯,SmolDocling在性能測試中用實力證明了自己並非“花架子”。在涉及各種文檔轉換任務的綜合基準測試中,SmolDocling的表現顯著優於許多體量更大的競爭模型。例如,在全頁文檔OCR任務中,與擁有70億參數的Qwen2.5VL和3.5億參數的Nougat相比,SmolDocling取得了明顯更高的準確率,其編輯距離(0.48)更低,F1分數(0.80)更高。

在公式轉錄方面,SmolDocling也達到了0.95的F1分數,與最先進的模型如GOT不相上下。更令人稱讚的是,SmolDocling還在代碼片段識別方面樹立了新的標杆,精確率和召回率分別高達0.94和0.91。這簡直是“小個子,大力氣”,在各個關鍵領域都展現出了驚人的實力!

“十八般武藝”:複雜文檔也能輕鬆搞定

SmolDocling與其他文檔OCR解決方案的不同之處在於,它能夠處理文檔中的各種複雜元素,包括代碼、圖表、公式和各種不同的佈局。它的能力不僅限於常見的科學論文,還能可靠地處理專利、表格和商業文檔。

通過DocTags提供全面的結構化元數據,SmolDocling消除了HTML或Markdown等格式固有的歧義,從而提高了文檔轉換的下游可用性。其緊湊的體積還使其能夠以極低的資源需求進行大規模的批量處理,爲大規模部署提供了經濟高效的解決方案。這意味着,以後企業在處理海量複雜文檔時,再也不用爲高昂的計算成本和複雜的流程而煩惱了。

總而言之,SmolDocling的發佈代表了文檔轉換技術的重大突破。它有力地證明了,緊湊型模型不僅能夠與大型基礎模型競爭,而且在關鍵任務中還能顯著超越它們。

研究人員成功地展示了,通過有針對性的訓練、創新的數據增強和像DocTags這樣的新型標記格式,可以克服傳統上與模型大小和複雜性相關的侷限性。SmolDocling的開源不僅爲OCR技術樹立了新的效率和多功能性標準,還通過開放的數據集和高效緊湊的模型架構,爲社區提供了一份寶貴的資源。