在人工智能領域,阿里通義實驗室團隊近日宣佈開源其最新研發的多模態模型 ——R1-Omni。這一模型結合了強化學習與可驗證獎勵(RLVR)方法,展現出了在處理音頻和視頻信息方面的卓越能力。R1-Omni 的亮點在於其透明性,讓我們得以更清晰地理解各模態在決策過程中的作用,尤其是在情緒識別等任務中。

隨着 DeepSeek R1的推出,強化學習在大模型的應用潛力被不斷挖掘。RLVR 方法爲多模態任務帶來了新的優化思路,能夠有效處理幾何推理、視覺計數等複雜任務。儘管目前的研究多集中於圖像和文本的結合,但通義實驗室的最新探索則拓展了這一領域,將 RLVR 與視頻全模態模型結合,充分展示了技術的廣泛應用前景。

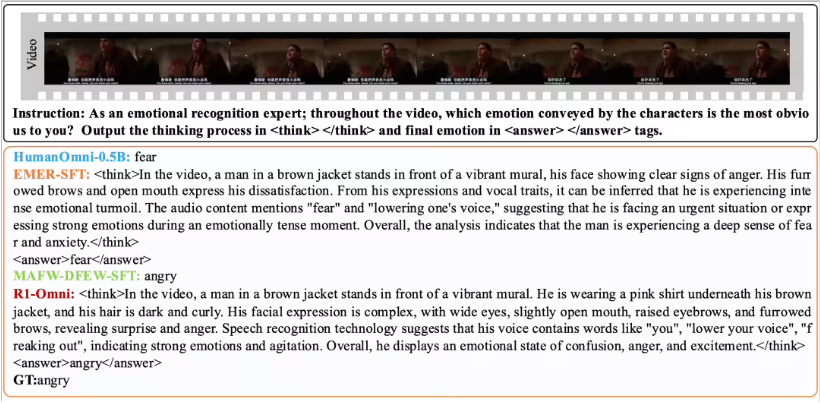

R1-Omni 通過 RLVR 方法,使音頻和視頻信息的影響變得更加直觀。例如,在情緒識別任務中,模型能夠清晰展示哪些音視頻信號對情緒判斷起到了關鍵作用。這種透明性不僅提高了模型的可靠性,也爲研究人員和開發者提供了更好的洞察。

在性能驗證方面,通義實驗室團隊將 R1-Omni 與原始 HumanOmni-0.5B 模型進行了對比實驗。結果表明,R1-Omni 在 DFEW 和 MAFW 數據集上的表現均有顯著提升,平均提高超過35%。此外,相較於傳統的監督微調(SFT)模型,R1-Omni 在無監督學習(UAR)上也提升了超過10%。在不同分佈測試集(如 RAVDESS)上,R1-Omni 展現出了卓越的泛化能力,WAR 和 UAR 均提高超過13%。這些成果不僅證明了 RLVR 在提升推理能力上的優勢,也爲未來的多模態模型研究提供了新的思路和方向。

R1-Omni 的開源將爲更多研究人員和開發者提供便利,期待這一模型在未來的應用中能夠帶來更多創新和突破。