阿里巴巴旗下的Qwen團隊近日推出了其最新的開源大型語言模型(LLM)家族成員——QwQ-32B。這款擁有320億參數的推理模型,旨在通過強化學習(RL)提升在複雜問題解決任務上的性能。

據介紹,QwQ-32B已在Hugging Face和ModelScope上以 Apache2.0許可證開源。這意味着該模型可用於商業和研究目的,企業能夠直接將其應用於產品和應用,包括那些收費的服務。個人用戶也可以通過Qwen Chat訪問該模型。

QwQ,全稱Qwen-with-Questions,是阿里巴巴於2024年11月首次推出的開源推理模型,目標是與OpenAI的o1-preview競爭。最初的QwQ通過在推理過程中審查和改進自身答案來增強邏輯推理和規劃能力,尤其在數學和編碼任務中表現出色。

此前的QwQ擁有320億參數和32,000tokens的上下文長度,並在AIME和MATH等數學基準測試以及GPQA等科學推理任務中超越了o1-preview。然而,早期版本的QwQ在LiveCodeBench等編程基準測試中表現相對較弱,並且面臨語言混合和偶爾的循環論證等挑戰。

儘管如此,阿里巴巴選擇以Apache2.0許可證發佈該模型,使其與OpenAI的o1等專有替代方案區分開來,允許開發者和企業自由地進行適配和商業化。隨着AI領域的發展,傳統LLM的侷限性日益顯現,大規模擴展帶來的性能提升逐漸減緩,這推動了對**大型推理模型(LRM)**的興趣。LRM通過推理時推理和自我反思來提高準確性,例如OpenAI的o3系列和DeepSeek-R1。

最新的QwQ-32B通過整合強化學習和結構化自我提問,進一步提升了性能,旨在成爲推理AI領域的重要競爭者。QwQ團隊的研究表明,強化學習可以顯著提高模型解決複雜問題的能力。QwQ-32B採用了多階段強化學習訓練方法,以增強數學推理、編碼能力和通用問題解決能力.

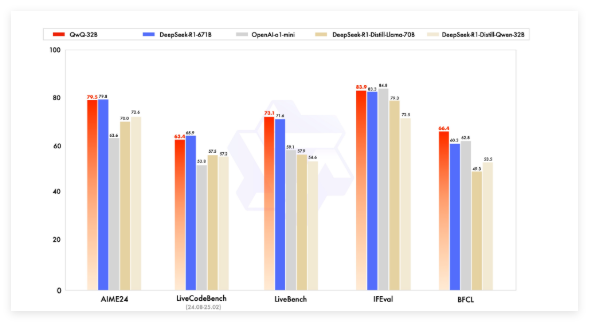

在基準測試中,QwQ-32B與DeepSeek-R1、o1-mini和DeepSeek-R1-Distilled-Qwen-32B等領先模型展開了競爭,並在參數量小於部分競品的情況下取得了有競爭力的結果。例如,DeepSeek-R1擁有6710億參數(激活370億),而QwQ-32B在性能相當的情況下,顯存需求更小,通常在GPU上需要24GB vRAM,而運行完整的DeepSeek R1則需要超過1500GB vRAM。

QwQ-32B採用了因果語言模型架構,並進行了多項優化,包括64個Transformer層、RoPE、SwiGLU、RMSNorm和Attention QKV bias。它還採用了廣義查詢注意力(GQA),擁有131,072tokens的擴展上下文長度,並經歷了包括預訓練、監督微調和強化學習在內的多階段訓練。

QwQ-32B的強化學習過程分爲兩個階段:首先專注於數學和編碼能力,利用準確性驗證器和代碼執行服務器進行訓練。第二階段則通過通用獎勵模型和基於規則的驗證器進行獎勵訓練,以提高指令跟隨、人類對齊和代理推理能力,同時不影響其數學和編碼能力。

QwQ-32B還具備agentic capabilities,能夠根據環境反饋動態調整推理過程。Qwen團隊建議使用特定的推理設置以獲得最佳性能,並支持使用vLLM進行部署。

Qwen團隊將QwQ-32B視爲通過擴展強化學習增強推理能力的第一步,未來計劃進一步探索擴展強化學習、整合代理與強化學習以實現長期推理,並持續開發爲強化學習優化的基礎模型,最終邁向通用人工智能(AGI)。

模型:https://qwenlm.github.io/blog/qwq-32b/

劃重點:

🚀 阿里巴巴推出開源推理大模型QwQ-32B,採用強化學習技術,提升複雜問題求解能力.

💡 QwQ-32B在數學、編程等基準測試中表現與更大參數模型相當,且顯存需求更低,並以Apache2.0協議開源,可免費商用.

🧠 該模型具備擴展上下文長度(13萬 tokens)和agentic capabilities,未來將繼續探索強化學習在提升模型智能方面的潛力.