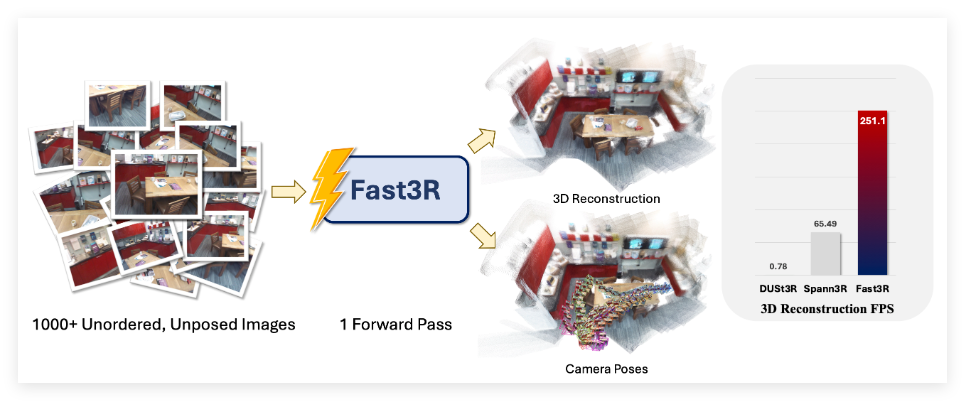

在計算機視覺領域,多視角3D 重建一直是一項重要且具挑戰性的任務,尤其是在需要精確且可擴展的表示時。現有的主流方法,例如 DUSt3R,主要採用成對處理的方式,這種方法在進行多視角重建時需要複雜的全局對齊程序,既耗時又耗力。爲了解決這一問題,研究團隊提出了 Fast3R,這是一種創新的多視角重建技術,它可以在一次前向傳播中處理多達1500張圖片,大幅提升了重建速度。

Fast3R 的核心是一個基於 Transformer 的架構,能夠並行處理多張視圖信息,從而省去迭代對齊的過程。這一新方法通過廣泛的實驗驗證了其在相機位姿估計和3D 重建任務中的出色表現,顯著提高了推理速度,並減少了誤差積累,使 Fast3R 成爲多視角應用中一種強有力的替代方案。

在 Fast3R 的實現中,研究者運用了一系列大規模模型訓練和推理技術,確保了高效且可擴展的處理能力。這些技術包括 FlashAttention2.0(用於內存高效的注意力計算)、DeepSpeed ZeRO-2(用於分佈式訓練優化)、位置嵌入插值(便於短期訓練和長期測試)以及張量並行(加速多 GPU 推理)。

在計算效率方面,Fast3R 在單張 A100GPU 上表現優異,顯示出相比 DUSt3R 的顯著優勢。例如,當處理32張分辨率爲512×384的圖像時,Fast3R 僅需0.509秒,而 DUSt3R 則需要129秒,且在處理48張圖像時便面臨內存溢出的問題。Fast3R 不僅在時間和內存消耗上表現突出,也在模型和數據規模方面展現出良好的擴展性,預示着其在大規模3D 重建中的廣闊前景。

項目入口:https://fast3r-3d.github.io/

劃重點:

🌟 Fast3R 技術可以在一次前向傳播中處理多達1500張圖片,大幅提高3D 重建速度。

⚡ Fast3R 的 Transformer 架構支持並行處理,省去傳統方法的複雜對齊過程。

🚀 與 DUSt3R 相比,Fast3R 在時間和內存使用上展現出顯著優勢,適用於大規模3D 重建應用。