日本人工智能初創公司Sakana AI宣佈推出“AI CUDA工程師”(AI CUDA Engineer),這一創新性的AI智能體系統旨在自動化生產高度優化的CUDA內核,顯著提升機器學習操作的運行效率。根據X平臺上的最新消息,該系統通過進化的大型語言模型(LLM)驅動代碼優化技術,將常見PyTorch操作的運行速度提高了10至100倍,標誌着AI技術在GPU性能優化領域的重大突破。

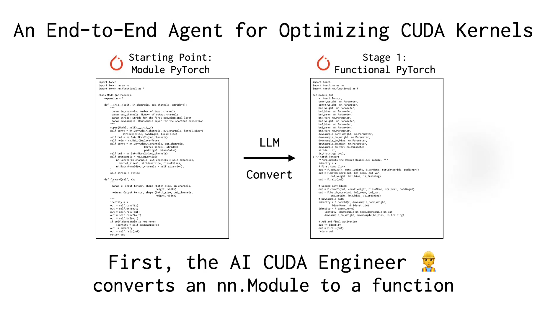

Sakana AI表示,CUDA內核作爲GPU計算的核心,直接編寫和優化通常需要深厚的專業知識和高技術門檻,而現有框架如PyTorch雖然使用便捷,但在性能上往往無法與手動優化的內核媲美。“AI CUDA工程師”通過智能化的工作流程解決了這一難題:它不僅能將PyTorch代碼自動轉化爲高效的CUDA內核,還通過進化算法進行性能調優,甚至能融合多個內核以進一步提升運行時效率。

X用戶@shao__meng將這一技術比喻爲“給AI開發裝上了自動變速箱”,讓普通代碼能夠“自動升級爲賽車級性能”。另一位用戶@FinanceYF5也在帖子中指出,該系統的推出展示了AI自優化的潛力,可能爲未來的計算資源使用效率帶來革命性提升。

Sakana AI此前已因“AI Scientist”等項目在業界嶄露頭角,此次“AI CUDA工程師”的發佈進一步凸顯了其在AI自動化領域的雄心。公司聲稱,該系統已成功生成並驗證了超過17,000個CUDA內核,覆蓋多種PyTorch操作,且公開的數據集將爲研究人員和開發者提供寶貴資源。業內人士認爲,這一技術不僅降低了高性能GPU編程的門檻,還可能推動人工智能模型的訓練和部署效率邁上新臺階。

信息參考:https://x.com/FinanceYF5/status/1892856847780237318