據豆包大模型團隊官方公衆號消息,在北京交通大學和中國科學技術大學的聯合研究下,由豆包大模型團隊提出的 “VideoWorld” 視頻生成實驗模型近日正式開源。

這個模型的最大亮點在於,它不再依賴傳統的語言模型,而是僅憑視覺信息就能認知和理解世界。這一突破性的研究靈感來源於李飛飛教授在 TED 演講中提到的 “幼兒可以不依靠語言理解真實世界” 的理念。

“VideoWorld” 通過分析和處理大量視頻數據,實現了複雜的推理、規劃和決策能力。研究團隊的實驗顯示,模型在僅有300M 參數的情況下,便取得了顯著的效果。與現有依賴語言或標籤數據的模型不同,VideoWorld 能夠獨立進行知識學習,尤其在摺紙、打領結等複雜任務中,能夠提供更加直觀的學習方式。

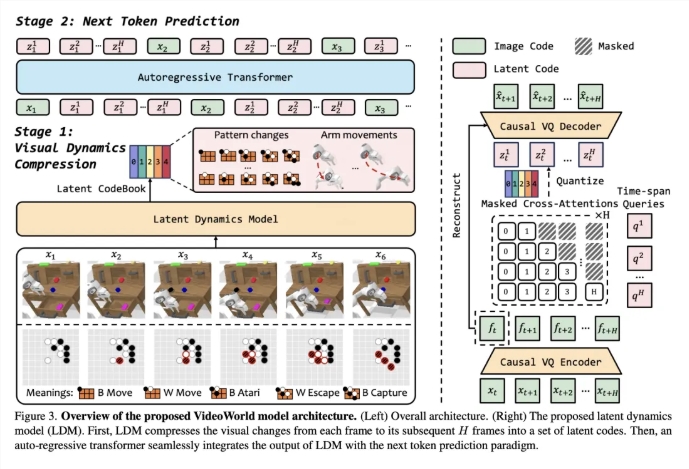

爲了驗證該模型的有效性,研究團隊搭建了圍棋對戰和機器人模擬操控兩種實驗環境。圍棋作爲一項高度策略性遊戲,可以有效評估模型的規則學習和推理能力,而機器人任務則考察模型在控制和規劃方面的表現。在訓練階段,模型通過觀看大量視頻演示數據,逐步建立起對未來畫面的預測能力。

爲了提高視頻學習的效率,團隊引入了一種潛在動態模型(LDM),旨在壓縮視頻幀之間的視覺變化,從而提取出關鍵信息。這一方法不僅減少了冗餘信息,還增強了模型對複雜知識的學習效率。通過這一創新,VideoWorld 在圍棋和機器人任務中展示了出色的能力,甚至達到了專業五段圍棋的水平。

論文鏈接:https://arxiv.org/abs/2501.09781

代碼鏈接:https://github.com/bytedance/VideoWorld

項目主頁:https://maverickren.github.io/VideoWorld.github.io

劃重點:

🌟 “VideoWorld” 模型僅憑視覺信息即可實現知識學習,不依賴語言模型。

🤖 模型在圍棋和機器人模擬任務中展現出卓越的推理和規劃能力。

🔓 該項目代碼與模型已開源,歡迎各界人士參與體驗與交流。