Hugging Face 推出了一款令人矚目的 AI 模型 ——SmolVLM。這款視覺語言模型的體積小到可以在手機等小型設備上運行,且性能超越了那些需要大型數據中心支持的前輩模型。

SmolVLM-256M 模型的 GPU 內存需求不足1GB,性能卻超過了其前代 Idefics80B 模型,這一後者的規模是其300倍,標誌着實用 AI 部署的一個重大進展。

根據 Hugging Face 機器學習研究工程師安德烈斯・馬拉菲奧提的說法,SmolVLM 模型在推向市場的同時,也爲企業帶來了顯著的計算成本降低。“我們之前發佈的 Idefics80B 在2023年8月是首個開源的視頻語言模型,而 SmolVLM 的推出則實現了300倍的體積縮減,同時性能提升。” 馬拉菲奧提在接受《創業者日報》採訪時表示。

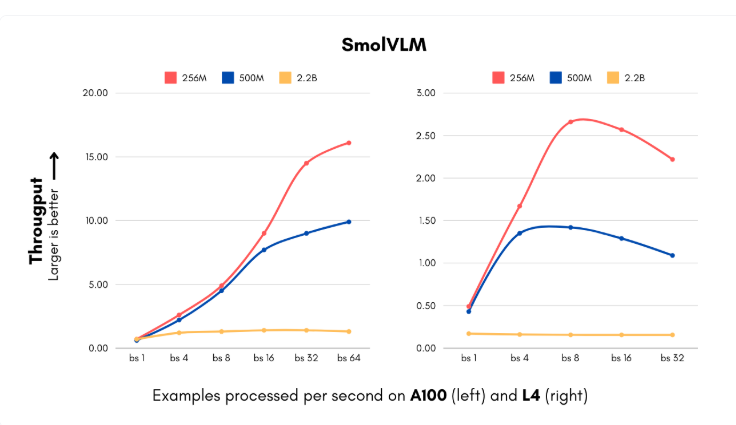

SmolVLM 模型的推出恰逢企業在人工智能系統實施方面面臨高昂計算成本的關鍵時刻。新模型包括256M 和500M 兩種參數規模,可以以以前無法想象的速度處理圖像和理解視覺內容。最小版本的處理速度可達每秒16個實例,僅需15GB 的內存,特別適合那些需要處理大量視覺數據的企業。對於每月處理100萬張圖片的中型公司而言,這意味着可觀的年度計算成本節省。

此外,IBM 也與 Hugging Face 達成了合作,將256M 模型集成到其文檔處理軟件 Docling 中。儘管 IBM 擁有豐富的計算資源,但使用更小的模型使得其以更低的成本高效處理數百萬份文件。

Hugging Face 團隊通過對視覺處理和語言組件的技術創新,成功減少了模型規模而不損失性能。他們將原先的400M 參數視覺編碼器更換爲93M 參數版本,並實施了更激進的令牌壓縮技術。這些創新使得小型企業和初創公司能夠在短時間內推出複雜的計算機視覺產品,基礎設施成本也大幅降低。

SmolVLM 的訓練數據集包含了1.7億個訓練示例,其中近一半用於文檔處理和圖像標註。這些發展不僅降低了成本,還爲企業帶來了全新的應用可能性,使得企業在視覺搜索方面的能力提升至前所未有的水平。

Hugging Face 的這一進展挑戰了傳統對模型規模與能力之間關係的看法。SmolVLM 證明小型高效架構同樣能夠實現出色的表現,未來 AI 的發展或許將不再是追求更大的模型,而是追求更靈活高效的系統。

模型:https://huggingface.co/blog/smolervlm

劃重點:

🌟 Hugging Face 推出的 SmolVLM 模型能在手機上運行,性能超越300倍大的 Idefics80B 模型。

💰 SmolVLM 模型幫助企業顯著降低計算成本,處理速度達到每秒16個實例。

🚀 該模型的技術創新讓小型企業和初創公司能夠在短時間內推出複雜的計算機視覺產品。