近年來,視覺大模型(Large Vision Language Models, LVLMs)在圖像理解和跨模態任務中展現出非凡的能力,然而隨之而來的 “幻覺現象” 問題也日益突出。爲了應對這一挑戰,淘天集團的未來生活實驗室團隊提出了一種名爲 “令牌偏好優化”(Token Preference Optimization,簡稱 TPO)的新方法,並引入了一種自我校準的視覺錨定獎勵機制。

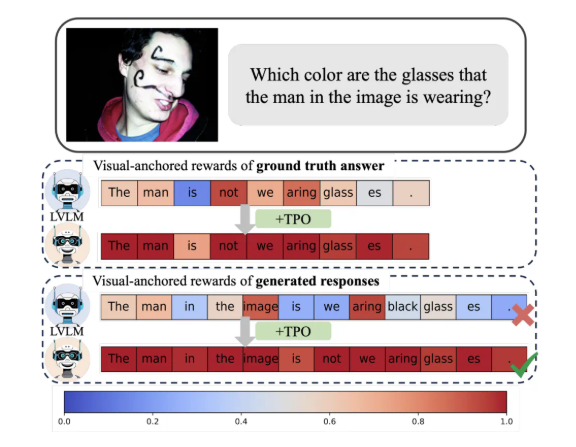

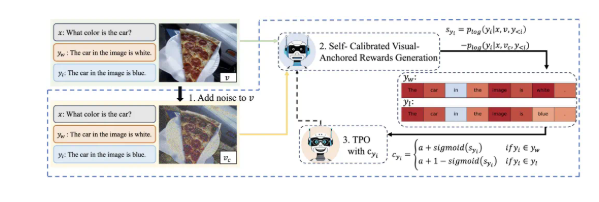

TPO 的最大創新在於它實現了自動化的令牌級獎勵信號。這一方法能夠自動識別偏好數據中的視覺錨定令牌,避免了人工細粒度標註的繁瑣,同時在訓練過程中爲每個令牌分配了反映其與視覺信息依賴程度的獎勵。這一自校準的視覺錨定獎勵信號,旨在優化模型對視覺信息的依賴性,從而有效減輕幻覺現象的發生。

研究表明,採用 TPO 的模型在多個評測基準中顯著優於傳統的方法,尤其是在更復雜的任務中,模型生成的答案越來越依賴於圖像信息而非語言模型的先驗知識。這一進步不僅提升了模型的理解能力,也爲進一步研究提供了重要的理論基礎。

此外,研究團隊還對 TPO 的不同參數設置進行了消融實驗,發現優化的加噪步驟和獎勵分配策略能夠進一步提高模型性能。這一發現無疑爲未來的視覺大模型研究和應用指明瞭方向。

總之,淘天的這一創新成果爲多模態對齊技術提供了新的思路,推動了 AI 技術在生活和消費領域的深入應用。