隨着大型語言模型(LLMs)在自然語言處理(NLP)領域的廣泛應用,文本生成和語言理解等任務的效果得顯著提升。然而,阿拉伯語由於其複雜的詞形變化、豐富的方言和文化背景,依然在語言模型的應用中被低估。

許多先進的語言模型主要針對英語,導致阿拉伯語相關模型要麼過於龐大,計算需求高,要麼無法充分體現文化細節。超過70億參數的模型如 Jais 和 AceGPT 具備強大的能力,但由於資源消耗巨大,難以在廣泛應用中得到推廣。因此,迫切需要一種兼顧效率與性能的阿拉伯語模型。

爲了解決這一問題,Stability AI 推出了阿拉伯語 Stable LM1.6B 模型,包括基礎版和聊天版。這一模型作爲阿拉伯語中心的 LLM,針對其規模在文化對齊和語言理解基準測試中取得了優異的成績。與超過70億參數的大型模型不同,阿拉伯語 Stable LM1.6B 在保持良好性能的同時,減少了計算需求。

該模型在超過1000億個阿拉伯語文本標記上進行了精細調優,確保了現代標準阿拉伯語和各種方言的強大代表性。特別是聊天版模型在文化基準測試中表現出色,展現了較強的準確性和上下文理解能力。

Stability AI 的這一新模型融合了現實世界的指令數據集和合成對話生成,使其能夠有效處理文化細膩的查詢,同時在各種 NLP 任務中保持廣泛的適用性。

在技術方面,阿拉伯語 Stable LM1.6B 採用了針對阿拉伯語言特點的先進預訓練架構,關鍵設計要素包括:

標記優化 :模型使用 Arcade100k 標記器,平衡標記粒度和詞彙規模,減少阿拉伯文本中的過度標記問題。

多樣化數據集覆蓋 :訓練數據來源廣泛,包括新聞文章、網絡內容和電子書,確保對文學和口語阿拉伯語的全面代表。

指令調優 :數據集中包含合成的指令 - 響應對,包括重述對話和多項選擇問題,提高了模型處理文化特定任務的能力。

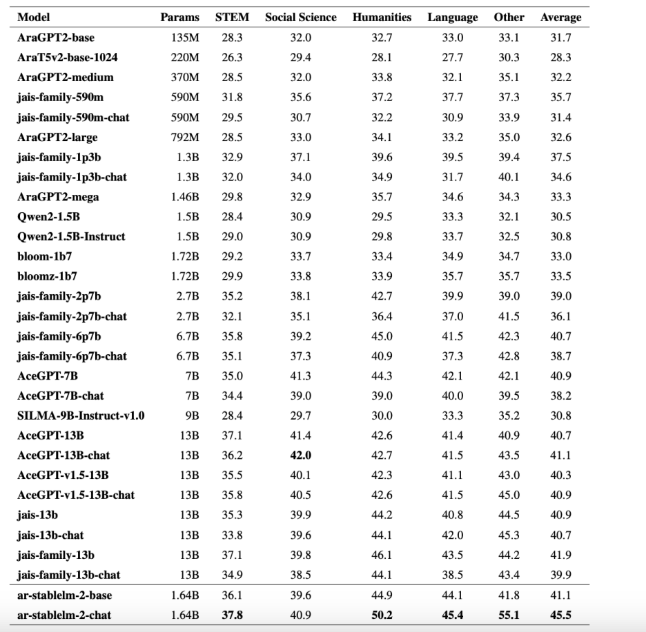

阿拉伯語 Stable LM1.6B 模型在阿拉伯 NLP 領域標誌着重要的進展,在如 ArabicMMLU 和 CIDAR-MCQ 等基準測試中取得了強勁的成績。例如,聊天版在 ArabicMMLU 基準測試中得分45.5%,超越了參數介於7億至130億之間的其他模型。在 CIDAR-MCQ 基準測試中,聊天模型的表現也相當強勁,得分達到了46%。

通過結合真實和合成數據集,該模型實現了可擴展性,同時保持了實用性,適用於多種 NLP 應用。阿拉伯語 Stable LM1.6B 的推出不僅解決了阿拉伯 NLP 中的計算效率和文化對齊問題,還爲阿拉伯語自然語言處理任務提供了可靠的工具。

聊天模型:https://huggingface.co/stabilityai/ar-stablelm-2-chat

基礎模型:https://huggingface.co/stabilityai/ar-stablelm-2-base

論文:https://arxiv.org/abs/2412.04277

劃重點:

🌟 阿拉伯語 Stable LM1.6B 模型旨在解決阿拉伯語 NLP 中的計算效率與文化對齊問題。

📈 該模型在多個基準測試中表現優異,超越了許多更大參數的模型。

🌐 Stability AI 通過融合現實數據合成數據,實現了阿拉伯語模型的實用性與可擴展性。