在當前大型語言模型(LLM)開發的競爭中,各大人工智能公司面臨着越來越多的挑戰,因此,越來越多的目光開始轉向 “Transformer” 以外的替代架構。Transformer 架構自2017年由谷歌研究人員提出以來,已成爲當今生成式人工智能的基礎。爲了應對這一挑戰,由麻省理工學院孵化的初創公司 Liquid AI 推出了一種名爲 STAR(Synthesis of Tailored Architectures)的創新框架。

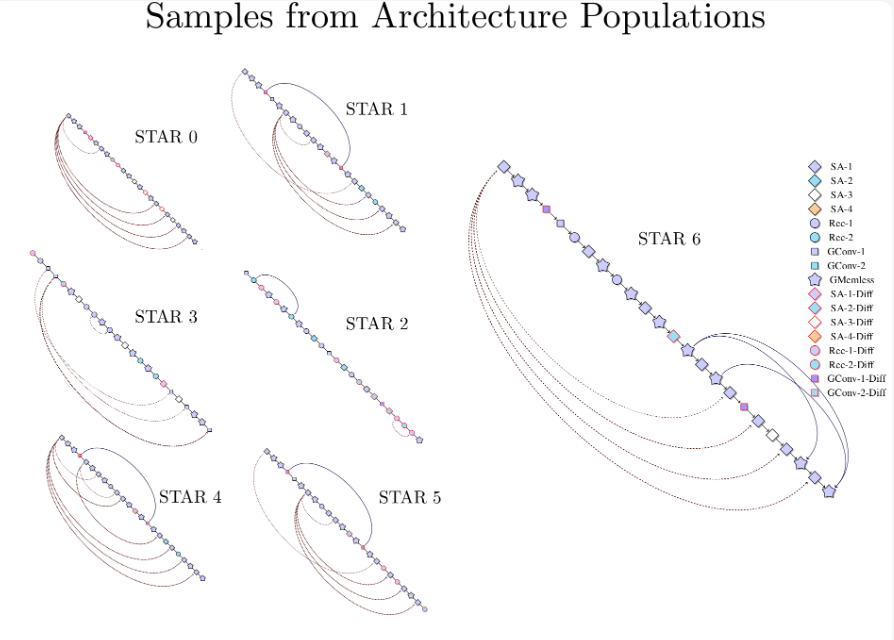

STAR 框架利用進化算法和數值編碼系統,旨在自動化生成和優化人工智能模型架構。Liquid AI 的研究團隊指出,STAR 的設計方法不同於傳統架構設計,它採用了分層編碼技術,稱爲 “STAR 基因組”,從而探索潛在架構的廣泛設計空間。通過基因組的組合與變異,STAR 能夠合成和優化符合特定性能和硬件需求的架構。

在針對自迴歸語言建模的測試中,STAR 顯示出優於傳統優化 Transformer++ 和混合模型的能力。在優化質量和緩存大小方面,STAR 進化的架構相較於混合模型的緩存大小減少了高達37%,而相較於傳統 Transformer 則達到了90% 的減少。這種高效性並未犧牲模型的預測性能,反而在某些情況下超越了競爭對手。

研究還表明,STAR 的架構可擴展性強,一個從1.25億參數擴展到10億參數的 STAR 進化模型在標準基準測試中表現與現有的 Transformer++ 和混合模型相當或更好,同時顯著降低了推理緩存需求。

Liquid AI 表示,STAR 的設計理念融入了動態系統、信號處理和數值線性代數的原理,構建了一個靈活的計算單元搜索空間。STAR 的一大特色在於其模塊化設計,使得它能夠在多個層次上編碼和優化架構,爲研究人員提供了洞察有效架構組件組合的機會。

Liquid AI 認爲 STAR 的高效架構合成能力將應用於各種領域,尤其是在需要平衡質量與計算效率的場景。雖然 Liquid AI 尚未公佈具體的商業部署或定價計劃,但其研究成果標誌着自動化架構設計領域的一次重大進步。隨着 AI 領域的不斷演進,像 STAR 這樣的框架可能會在塑造下一代智能系統中發揮重要作用。

官方博客:https://www.liquid.ai/research/automated-architecture-synthesis-via-targeted-evolution

劃重點:

🌟 Liquid AI 推出的 STAR 框架通過進化算法自動生成和優化 AI 模型架構。

📉 STAR 模型在緩存大小方面減少了高達90%,並在性能上超過傳統 Transformer。

🔍 STAR 的模塊化設計可應用於多個領域,推動 AI 系統優化的進一步發展。