熬夜肝文獻綜述?抓耳撓腮寫論文?別慌!AI2的科研大神們帶着他們的最新力作OpenScholar來拯救你了!這款科研效率神器,能讓文獻綜述像逛公園一樣輕鬆愉快!

OpenScholar的最大祕密武器,就是一個叫做OpenScholar-Datastore (OSDS)4.5億篇開放獲取論文,還有2.37億個文章段落嵌入。有了這麼強大的知識儲備,OpenScholar才能遊刃有餘地應對各種科研難題。

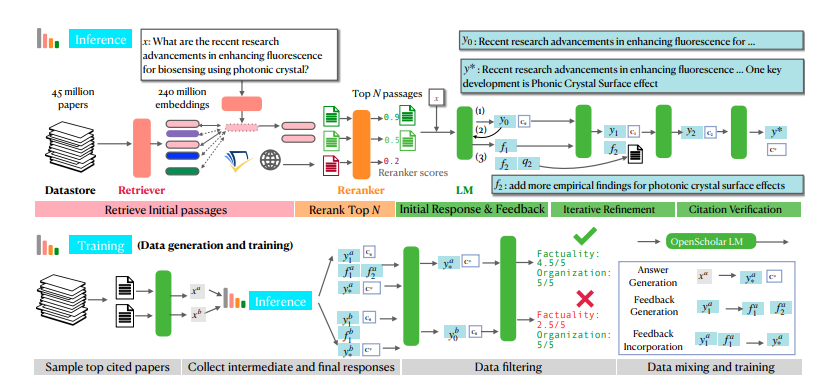

當你遇到一個科研問題時,OpenScholar首先會派出它的得力干將——檢索器和重新排序器,從OSDS中快速篩選出與你的問題相關的文章段落。接着,一個語言模型 (LM)包含參考文獻的完整答案。更厲害的是,OpenScholar還會根據你的自然語言反饋不斷改進答案,補充缺失的信息,直到你滿意爲止。

OpenScholar不僅自己很強大,還能幫助訓練更小巧、更高效的模型。研究人員利用OpenScholar的流程,生成了海量的高質量訓練數據,並用這些數據訓練了一個名爲OpenScholar-8B的80億參數語言模型,以及其他檢索模型。

爲了全面檢驗OpenScholar的戰鬥力,研究人員還專門打造了一個名爲SCHOLARQABENCH的全新測試擂臺。這個擂臺上設置了各種各樣的科學文獻綜述任務,包括封閉式分類、多項選擇和長篇生成,涵蓋了計算機科學、生物醫學、物理學和神經科學等多個領域。爲了保證比賽的公平公正,SCHOLARQABENCH還採用了多方面評估方法,包括專家評審、自動指標以及用戶體驗測試。

經過多輪激烈角逐,OpenScholar最終脫穎而出!實驗結果表明,它在各項任務中都表現出色,甚至超越了人類專家!這項突破性的成果必將掀起科研領域的一場革命,讓科學家們告別文獻綜述的苦海,專注於探索科學的奧祕!

OpenScholar的強大功能主要得益於其獨特的自我反饋檢索增強推理機制。簡單來說,就是它會先自己給自己提問題,然後根據自己的回答不斷改進答案,最後再把最完美的答案呈現給你。是不是很神奇?

具體來說,OpenScholar的自我反饋推理過程分爲三個步驟:初始答案生成、反饋生成和反饋整合。 首先,語言模型會根據檢索到的文章段落生成一個初始答案。接着,它會像一個嚴厲的考官一樣,對自己的答案進行自我批評,找出不足之處,並生成一些自然語言反饋,比如“答案只包含了關於問答任務的實驗結果,請補充其他類型任務的結果”。 最後,語言模型會根據這些反饋重新檢索相關文獻,並整合所有信息,生成一個更加完善的答案。

爲了訓練更小巧但性能同樣強大的模型,研究人員還利用OpenScholar的自我反饋推理流程生成了大量的高質量訓練數據。 他們先從數據庫中挑選出引用次數最多的論文,然後根據這些論文的摘要生成一些信息查詢問題,最後再用OpenScholar的推理流程生成高質量的答案。這些答案和中間生成的反饋信息就構成了寶貴的訓練數據。 研究人員將這些數據與現有的通用領域指令微調數據和科學領域指令微調數據混合在一起,訓練出了一個名爲OpenScholar-8B的80億參數語言模型。

爲了更全面地評估OpenScholar和其他類似模型的性能,研究人員還創建了一個名爲SCHOLARQABENCH的全新基準測試。 這個基準測試包含了2967個由專家撰寫的文獻綜述問題,涵蓋了計算機科學、物理學、生物醫學和神經科學等四個領域。每個問題都有專家撰寫的長篇答案,平均每個答案需要專家花費大約一個小時的時間來完成。 SCHOLARQABENCH還採用了一種多方面評估方法,結合了自動指標和人工評估,可以更全面地衡量模型生成答案的質量。

實驗結果表明,OpenScholar在SCHOLARQABENCH上的表現遠遠超過了其他模型,甚至在某些方面超越了人類專家! 例如,在計算機科學領域,OpenScholar-8B的正確率比GPT-4o高出5%,比PaperQA2高出7%。 而且,OpenScholar生成答案的引用準確率也與人類專家不相上下,而GPT-4o則高達78-90%憑空捏造的。

OpenScholar的出現,無疑是科研領域的一大福音!它不僅能幫助科研人員節省大量時間和精力,還能提高文獻綜述的質量和效率。相信在不久的將來,OpenScholar將會成爲科研人員不可或缺的得力助手!

論文地址:https://arxiv.org/pdf/2411.14199

項目地址:https://github.com/AkariAsai/OpenScholar