聽說過ChatGPT、文心一言這些高大上的AI嗎?它們背後的核心技術就是“大型語言模型”(LLM)。是不是覺得很複雜,很難理解?別擔心,即使你只有小學二年級的數學水平,看完這篇文章,也能輕鬆掌握LLM的運行原理!

神經網絡:數字的魔法

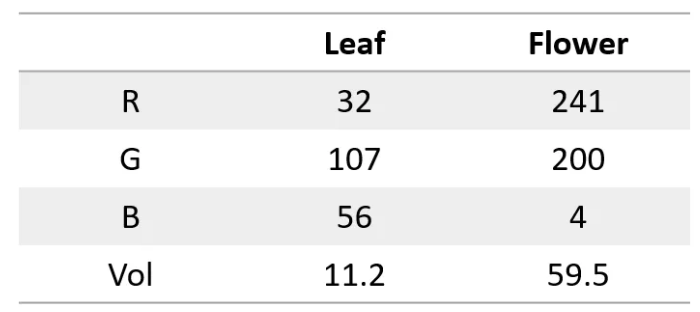

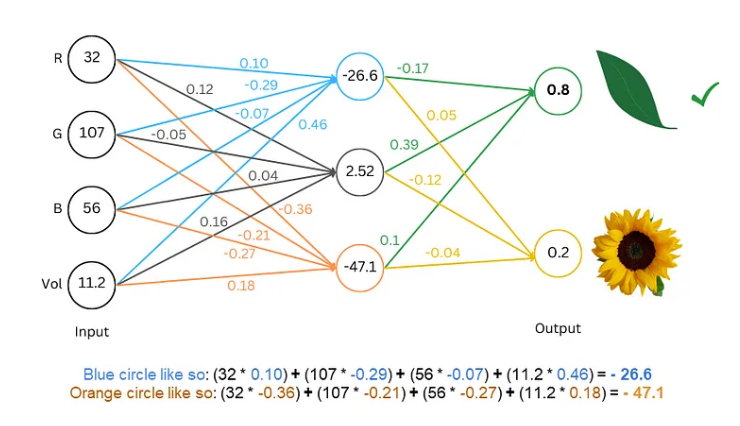

首先,我們要知道,神經網絡就像一個超級計算器,它只能處理數字。無論是輸入還是輸出,都必須是數字。那我們要怎麼讓它理解文字呢?

祕訣就在於把文字轉化成數字! 比如,我們可以把每個字母用一個數字代表,比如a=1,b=2,以此類推。這樣一來,神經網絡就能“讀懂”文字了。

訓練模型:讓網絡“學會”語言

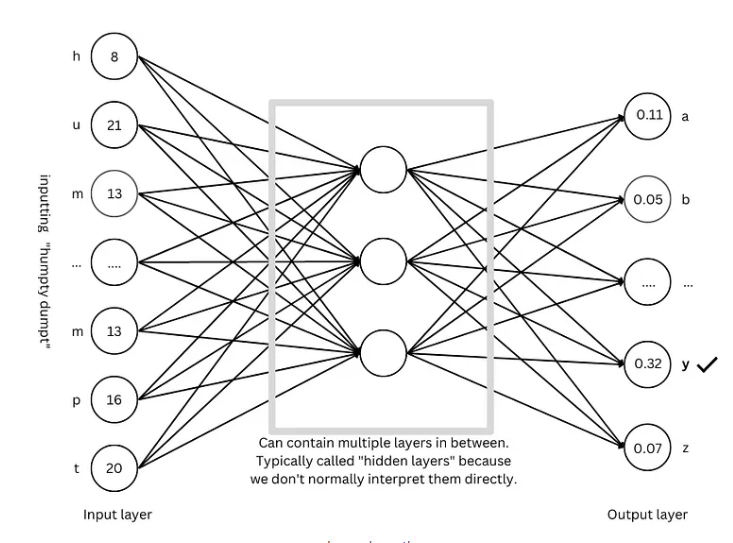

有了數字化的文字,接下來就要訓練模型,讓神經網絡“學會”語言的規律。

訓練的過程就像玩猜謎遊戲。 我們給網絡看一些文字,比如“Humpty Dumpty”,然後讓它猜下一個字母是什麼。如果它猜對了,我們就給它獎勵;如果猜錯了,就給它懲罰。通過不斷地猜謎和調整,網絡就能越來越準確地預測下一個字母,最終生成完整的句子,比如“Humpty Dumpty sat on a wall”。

進階技巧:讓模型更“聰明”

爲了讓模型更“聰明”,研究人員發明了許多進階技巧,比如:

詞嵌入: 我們不再用簡單的數字代表字母,而是用一組數字(向量)來代表每個詞,這樣可以更全面地描述詞語的含義。

子詞分詞器: 把單詞拆分成更小的單位(子詞),比如把“cats”拆成“cat”和“s”,這樣可以減少詞彙量,提高效率。

自注意力機制: 模型在預測下一個詞時,會根據上下文中的所有詞語來調整預測的權重,就像我們在閱讀時會根據上下文理解詞義一樣。

殘差連接: 爲了避免網絡層數過多導致訓練困難,研究人員發明了殘差連接,讓網絡更容易學習。

多頭注意力機制: 通過並行運行多個注意力機制,模型可以從不同的角度理解上下文,提高預測的準確性。

位置編碼: 爲了讓模型理解詞語的順序,研究人員會在詞嵌入中加入位置信息,就像我們在閱讀時會注意詞語的順序一樣。

GPT 架構:大型語言模型的“藍圖”

GPT 架構是目前最流行的大型語言模型架構之一,它就像一個“藍圖”,指引着模型的設計和訓練。GPT 架構巧妙地組合了上述的各種進階技巧,讓模型能夠高效地學習和生成語言。

Transformer 架構:語言模型的“革命”

Transformer 架構是近年來語言模型領域的一項重大突破,它不僅提高了預測的準確性,還降低了訓練的難度,爲大型語言模型的發展奠定了基礎。GPT 架構也是基於 Transformer 架構演變而來的。

參考資料:https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876