Meta Platforms今日發佈其Llama模型的全新精簡版本,包括Llama3.21B和3B兩款產品,首次實現了大規模語言模型在普通智能手機和平板電腦上的穩定運行。通過創新性地整合量化訓練技術與優化算法,新版本在保持原有處理質量的同時,將文件體積縮減56%,運行內存需求降低41%,處理速度更是提升至原版4倍,單次可連續處理8,000字符文本。

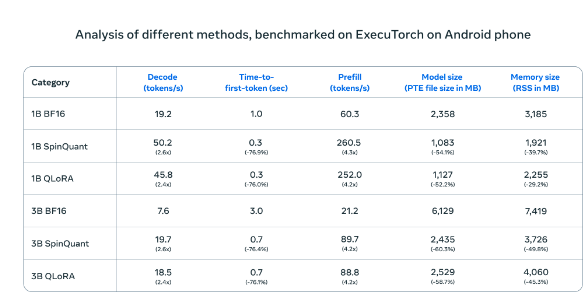

在 Android 手機上進行測試時,Meta 的壓縮 AI 模型(SpinQuant 和 QLoRA)與標準版本相比,速度和效率都有顯著提升。較小的模型運行速度提高了四倍,而內存佔用卻減少了

在OnePlus12手機的實際測試中,這款壓縮版本展現出與標準版本相當的性能表現,同時大幅提升了運行效率,有效解決了移動設備算力不足的長期困擾。Meta選擇採取開放合作的市場策略,與高通、聯發科等主流移動處理器製造商展開深度合作,新版本將通過Llama官方網站和Hugging Face平臺同步發佈,爲開發者提供便捷的接入渠道。

這一策略與行業其他巨頭形成鮮明對比。當谷歌和蘋果選擇將新技術與其操作系統深度整合時,Meta的開放路線爲開發者提供了更大的創新空間。此次發佈標誌着數據處理模式正從集中式服務器向個人終端轉變,本地處理方案不僅能更好地保護用戶隱私,還能提供更快捷的響應體驗。

這項技術突破可能引發如同個人電腦普及時期的重大變革,儘管仍面臨設備性能要求、開發者平臺選擇等挑戰。隨着移動設備性能的持續提升,本地化處理方案的優勢將逐步顯現。Meta期望通過開放合作的方式,推動整個行業向更高效、更安全的方向發展,爲移動設備的未來應用開發開闢新途徑。