智源研究院推出了一個名爲Infinity-Instruct的千萬級指令微調數據集,旨在提升語言模型在對話等方面的性能。近日,Infinity Instruct完成了新一輪迭代,包括Infinity-Instruct-7M基礎指令數據集和Infinity-Instruct-Gen對話指令數據集。

Infinity-Instruct-7M基礎指令數據集包含超過744萬條數據,涵蓋數學、代碼、常識問答等領域,致力於提升預訓練模型的基礎能力。測試結果顯示,使用此數據集微調的Llama3.1-70B和Mistral-7B-v0.1模型,在綜合能力上已接近官方發佈的對話模型,其中Mistral-7B甚至超過了GPT-3.5,而Llama3.1-70B接近GPT-4。

Infinity-Instruct-Gen對話指令數據集則包含149萬條合成的複雜指令,目的是提高模型在真實對話場景中的魯棒性。使用此數據集進行進一步微調後,模型的表現可超過官方對話模型。

智源研究院在MTBench、AlpacaEval2、Arena-Hard等主流評測榜單上對Infinity-Instruct進行了測試,結果表明,經過Infinity-Instruct微調的模型在對話能力上已超越了官方模型。

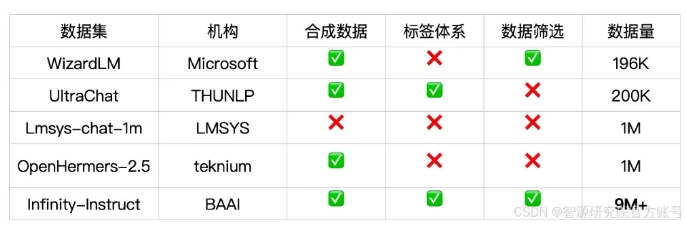

Infinity-Instruct爲每條指令數據提供了詳細的標註,如語種、能力類型、任務類型和數據來源,方便用戶根據需求篩選數據子集。智源研究院通過數據選擇與指令合成的方式構建了高質量的數據集,以彌補開源對話模型與GPT-4之間的差距。

項目還採用了FlagScale訓練框架來降低微調成本,並通過MinHash去重和BGE檢索剔除重複樣本。智源計劃未來開源數據處理和模型訓練的全流程代碼,並探索將Infinity-Instruct數據策略擴展到對齊、預訓練階段,以支持語言模型的全生命週期數據需求。

數據集鏈接:

https://modelscope.cn/datasets/BAAI/Infinity-Instruct