在人工智能領域,讓機器像人類一樣理解複雜的物理世界一直是一個重大挑戰。近日,由中國人民大學、北京郵電大學和上海AI Lab等機構組成的研究團隊提出了一項突破性技術——Ref-AVS,爲解決這一難題帶來了新的希望。

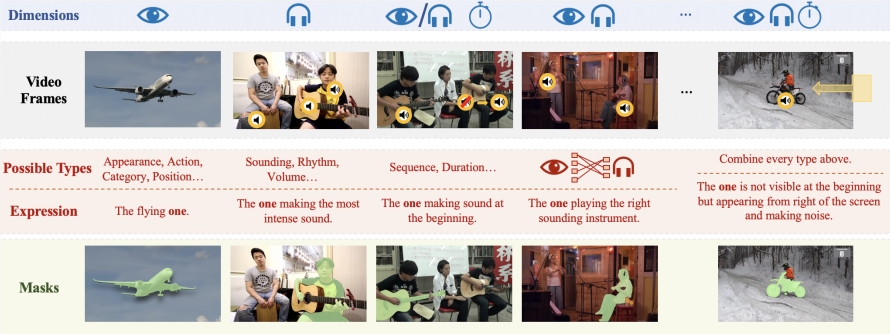

Ref-AVS技術的核心在於其獨特的多模態融合方法。它巧妙地整合了視頻對象分割(VOS)、視頻對象參考分割(Ref-VOS)和視聽分割(AVS)等多種模態信息。這種創新性的融合使得AI系統不僅能夠處理正在發聲的物體,還能識別場景中不發聲但同樣重要的物體。這一突破讓AI能更準確地理解用戶通過自然語言描述的指令,並在複雜的視聽場景中精確定位特定物體。

爲支撐Ref-AVS技術的研究和驗證,研究團隊構建了名爲Ref-AVS Bench的大規模數據集。這個數據集包含了40,020個視頻幀,涵蓋6,888個物體和20,261個指代表達式。每個視頻幀都配有相應的音頻和像素級的詳細標註。這個豐富多樣的數據集爲多模態研究提供了堅實的基礎,也爲未來相關領域的研究開闢了新的可能性。

在一系列嚴格的定量和定性實驗中,Ref-AVS技術展現出了卓越的性能。特別是在Seen子集上,Ref-AVS的表現超越了現有的其他方法,充分證明了其強大的分割能力。更值得注意的是,在Unseen和Null子集上的測試結果進一步驗證了Ref-AVS技術優秀的泛化能力和對空引用的魯棒性,這對於實際應用場景至關重要。

Ref-AVS技術的成功不僅在學術界引起了廣泛關注,也爲未來的實際應用開闢了新的道路。我們可以預見,這項技術將在視頻分析、醫療圖像處理、自動駕駛和機器人導航等多個領域發揮重要作用。例如,在醫療領域,Ref-AVS可能幫助醫生更準確地解讀複雜的醫學影像;在自動駕駛領域,它可能提升車輛對周圍環境的感知能力;在機器人技術中,它可能讓機器人更好地理解和執行人類的口頭指令。

這項研究成果已在ECCV2024上展示,相關論文和項目信息也已公開,爲全球對此領域感興趣的研究者和開發者提供了寶貴的學習和探索資源。這種開放共享的態度不僅體現了中國科研團隊的學術精神,也將推動整個AI領域的快速發展。

Ref-AVS技術的出現,標誌着人工智能在多模態理解方面邁出了重要一步。它不僅展示了中國科研團隊在AI領域的創新能力,也爲人機交互的未來描繪了一幅更加智能、自然的藍圖。隨着這項技術的不斷完善和應用,我們有理由期待,未來的AI系統將能更好地理解和適應人類的複雜世界,爲各行各業帶來革命性的變革。

論文地址:https://arxiv.org/abs/2407.10957

項目主頁:

https://gewu-lab.github.io/Ref-AVS/