在如今科技公司紛紛追逐在設備上實現人工智能的時代,越來越多的小型語言模型(SLM)應運而生,能夠在資源受限的設備上運行。最近,Nvidia 的研究團隊利用前沿的模型剪枝和蒸餾技術,推出了 Llama-3.1-Minitron4B,這是 Llama3模型的壓縮版本。這個新模型在性能上不僅可以與更大的模型媲美,還能與同等規模的小型模型競爭,同時在訓練和部署上都顯得更加高效。

剪枝和蒸餾是創建更小、更高效語言模型的兩項關鍵技術。剪枝是指去除模型中不重要的部分,包括 “深度剪枝”—— 去掉整個層,和 “寬度剪枝”—— 去掉特定元素如神經元和注意力頭。而模型蒸餾則是從一個大模型(即 “教師模型”)轉移知識和能力到一個更小、更簡單的 “學生模型”。

蒸餾主要有兩種方式,第一種是通過 “SGD 訓練”,讓學生模型學習教師模型的輸入和響應,第二種是 “經典知識蒸餾”,在這裏,學生模型除了學習結果外,還要學習教師模型的內部激活。

在之前的一項研究中,Nvidia 的研究人員成功地將 Nemotron15B 模型通過剪枝和蒸餾的方式減少到一個8億參數的模型,最終又進一步精簡至4億參數。這個過程不僅在著名的 MMLU 基準測試中提高了16% 的性能,而且所需的訓練數據也比從頭訓練少了40倍。

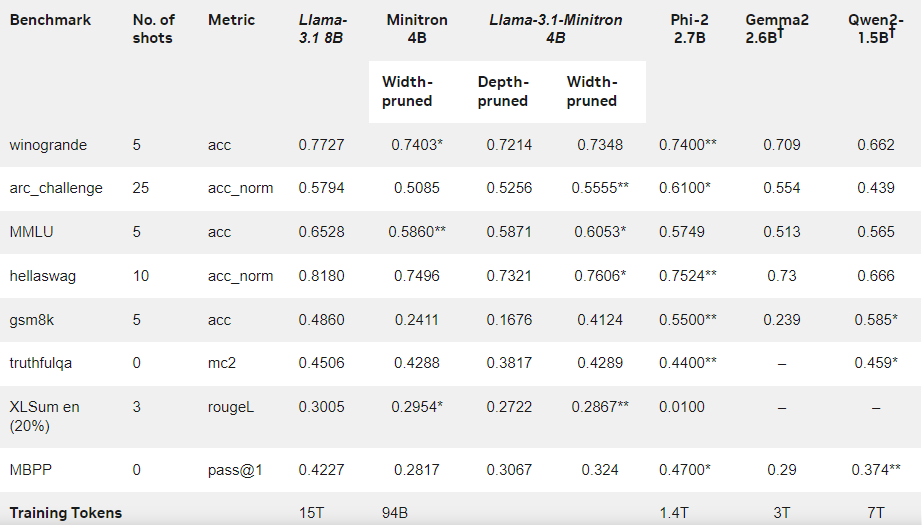

此次,Nvidia 團隊在 Llama3.18B 模型的基礎上,採用相同的方法打造出一個4億參數的模型。首先,他們在一個包含940億個標記的數據集上對未剪枝的8B 模型進行了微調,以應對訓練數據和蒸餾數據集之間的分佈差異。接着,採用了深度剪枝和寬度剪枝兩種方式,最終得到了 Llama-3.1-Minitron4B 的兩個不同版本。

研究人員通過 NeMo-Aligner 對剪枝後的模型進行了微調,並評估其在指令跟隨、角色扮演、檢索增強生成(RAG)和函數調用等方面的能力。

結果顯示,儘管訓練數據量較小,Llama-3.1-Minitron4B 的性能依然接近其他小型模型,表現出色。該模型的寬度剪枝版本已在 Hugging Face 上發佈,允許商業使用,幫助更多用戶和開發者受益於其高效和卓越的表現。

官方博客:https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model/

劃重點:

🌟 Llama-3.1-Minitron4B 是 Nvidia 基於剪枝和蒸餾技術推出的小型語言模型,具有高效的訓練和部署能力。

📈 該模型在訓練過程中使用的標記量比從頭訓練減少了40倍,性能卻有明顯提升。

🔓 寬度剪枝版本已在 Hugging Face 發佈,方便用戶進行商業使用和開發。