近日,AI界的知名研究員Andrej Karpathy拋出了一個頗具爭議的觀點,他認爲目前廣受推崇的基於人類反饋的強化學習(RLHF)技術可能並非通往真正人類級別問題解決能力的必由之路。這一言論無疑給當前AI研究領域投下了一枚重磅炸彈。

RLHF曾被視爲ChatGPT等大型語言模型(LLM)成功的關鍵因素,被譽爲賦予AI理解力、服從性和自然交互能力的"祕密武器"。在傳統的AI訓練流程中,RLHF通常作爲預訓練和監督式微調(SFT)之後的最後一個環節。然而,Karpathy卻將RLHF比作一種"瓶頸"和"權宜之計",認爲它遠非AI進化的終極解決方案。

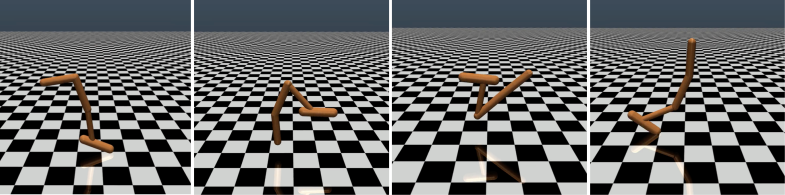

Karpathy巧妙地將RLHF與DeepMind公司的AlphaGo進行了對比。AlphaGo採用了他所稱的"真正的RL"(強化學習)技術,通過不斷與自己對弈並最大化勝率,最終在沒有人類干預的情況下超越了頂級人類棋手。這種方法通過優化神經網絡直接從遊戲結果中學習,達到了超越人類的表現水平。

相比之下,Karpathy認爲RLHF更像是在模仿人類偏好,而非真正解決問題。他設想如果AlphaGo採用RLHF方法,人類評估者將需要比較大量的棋局狀態並選擇偏好,這個過程可能需要高達10萬次比較才能訓練出一個模仿人類"氛圍檢查"的"獎勵模型"。然而,這種基於"氛圍"的評判在圍棋這樣的嚴謹遊戲中可能會產生誤導性結果。

同理,當前LLM的獎勵模型工作原理也類似——它傾向於對人類評估者在統計上似乎偏好的答案進行高排名。這更像是一種迎合人類表面喜好的代理,而非真正的問題解決能力的體現。更令人擔憂的是,模型可能會迅速學會如何利用這種獎勵函數,而非真正提升自身能力。

Karpathy指出,雖然強化學習在像圍棋這樣的封閉環境中表現出色,但對於開放式語言任務來說,真正的強化學習仍然難以實現。這主要是因爲在開放性任務中,很難定義明確的目標和獎勵機制。"如何爲總結一篇文章、回答關於pip安裝的模糊問題、講一個笑話或將Java代碼重寫爲Python等任務給出客觀的獎勵?"Karpathy提出了這個富有洞察力的問題,"朝這個方向發展並非原則上不可能,但也絕非易事,它需要一些創造性的思考。"

儘管如此,Karpathy仍然認爲,如果能夠解決這個難題,語言模型有望真正匹配甚至超越人類的問題解決能力。這一觀點與Google DeepMind最近發表的一篇論文不謀而合,該論文指出開放性是通用人工智能(AGI)的基礎。

作爲今年離開OpenAI的幾位高級AI專家之一,Karpathy最近正在爲自己的教育AI創業公司奔走。他的這番言論無疑爲AI研究領域注入了新的思考維度,也爲未來AI發展方向提供了寶貴的洞見。

Karpathy的觀點引發了業內廣泛討論。支持者認爲,他揭示了當前AI研究中的一個關鍵問題,即如何使AI真正具備解決複雜問題的能力,而不僅僅是模仿人類行爲。反對者則擔心,過早放棄RLHF可能會導致AI發展方向的偏離。

論文地址:https://arxiv.org/pdf/1706.03741