在當今時代,自然語言處理(NLP)領域發展迅速,大型語言模型(LLMs)能夠高精度地執行復雜的語言相關任務,爲人機交互帶來了更多可能。然而,NLP 中存在一個顯著問題,那就是模型評估對人類註釋的依賴。

人類生成的數據對於模型的訓練和驗證至關重要,但收集這些數據既昂貴又耗時。而且,隨着模型不斷改進,先前收集的註釋可能需要更新,其在評估新模型時的效用降低,這就導致需要持續獲取新數據,給有效模型評估的規模化和可持續性帶來了挑戰。

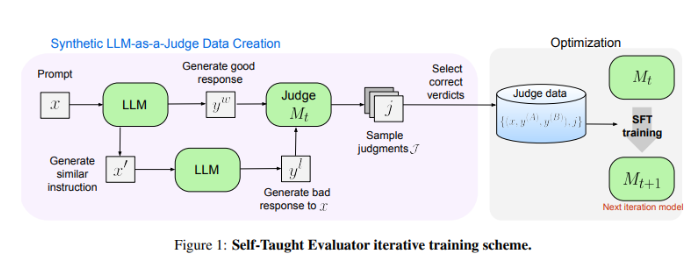

Meta FAIR 的研究人員帶來了全新的解決方案——“Self-Taught Evaluator”(自學評估器)。這一方法無需人類註釋,而是利用合成生成的數據進行訓練。首先通過種子模型生成對比的合成偏好對,然後模型對這些對進行評估並迭代改進,利用自己的判斷來提升後續迭代中的性能,大大降低了對人類生成註釋的依賴。

研究人員使用 Llama-3-70B-Instruct 模型對“自學評估器”的性能進行了測試。該方法將模型在 RewardBench 基準上的準確性從75.4提高到88.7,達到甚至超越了使用人類註釋訓練的模型性能。經過多次迭代,最終模型在單次推理中達到88.3的準確率,多數投票下達到88.7,展現出其強大的穩定性和可靠性。

“自學評估器”爲 NLP 模型評估提供了可擴展且高效的解決方案,利用合成數據和迭代自我改進,應對了依賴人類註釋的挑戰,推動了語言模型的發展。

論文地址:https://arxiv.org/abs/2408.02666

劃重點:

- 😃NLP 模型評估依賴人類註釋,存在收集數據成本高、耗時且效用易降低的問題。

- 🤖Meta FAIR 推出“Self-Taught Evaluator”,利用合成數據訓練,降低對人類註釋的依賴。

- 💪“自學評估器”性能出色,在測試中顯著提高模型準確率,表現穩定可靠。