最近,多個機構學者發現了一種新技術——物理神經網絡(PNNs)。這可不是我們熟知的,那些在電腦裏運行的數字算法,而是一種全新的,基於物理系統的智能計算方式。

PNNs,顧名思義,就是利用物理系統的特性來執行計算的神經網絡。雖然目前它還屬於研究領域的小衆領域,但它們可能是現代AI中被嚴重低估的重要機會之一。

PNNs的潛力:大模型、低能耗、邊緣計算

想象一下,如果我們能夠訓練比現在大1000倍的AI模型,而且還能實現在邊緣設備上進行本地、私密的推理,比如在智能手機或傳感器上,那會怎樣?這聽起來像是科幻小說裏的情節,但研究表明,這並非不可能。

要實現PNNs的大規模訓練,研究者們正在探索包括基於反向傳播和無反向傳播的方法。這些方法各有利弊,目前還沒有一種方法能夠像深度學習中廣泛使用的反向傳播算法那樣,實現同等規模和性能。但情況正在迅速改變,多樣化的訓練技術生態系統爲PNNs的利用提供了線索。

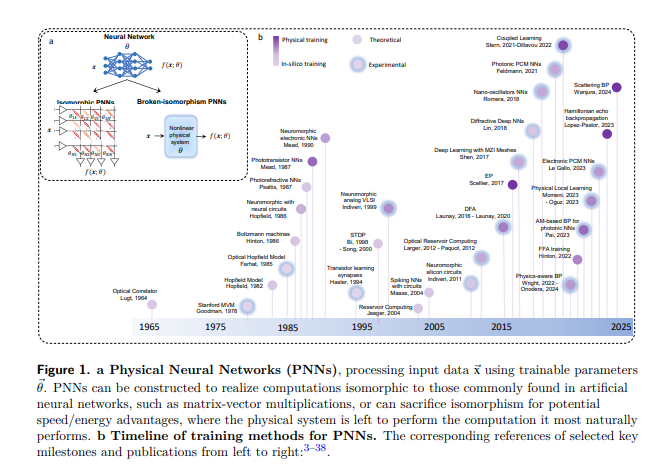

PNNs的實現涉及到多個領域,包括光學、電子學和類腦計算。它們可以採用與數字神經網絡結構相似的方式來執行矩陣-向量乘法等計算,也可以爲了潛在的速度/能量優勢而犧牲這種結構相似性,讓物理系統執行它最自然的計算。

PNNs的未來:超越數字硬件的性能

PNNs的未來應用可能會非常廣泛,從大型生成模型到智能傳感器中的分類任務。它們將需要被訓練,但根據不同的應用,訓練的約束可能會有所不同。理想的訓練方法應該是模型無關的、快速且能量效率高,並且對硬件的變異、漂移和噪聲具有魯棒性。

儘管PNNs的發展充滿了潛力,但它也面臨着不少挑戰。如何確保PNNs在訓練和推理階段的穩定性?如何將這些物理系統與現有的數字硬件和軟件基礎設施集成?這些都是需要解決的問題。

論文地址:https://arxiv.org/pdf/2406.03372