在人工智能領域,算力和時間一直是制約技術進步的關鍵因素。然而,DeepMind團隊的最新研究成果,爲這一難題提供瞭解決方案。

他們提出了一種名爲JEST的全新數據篩選方法,通過智能篩選最佳數據批次進行訓練,實現了AI訓練時間的大幅縮短和算力需求的顯著降低。據稱,可以將AI訓練時間減少13倍,並將算力需求降低90%。

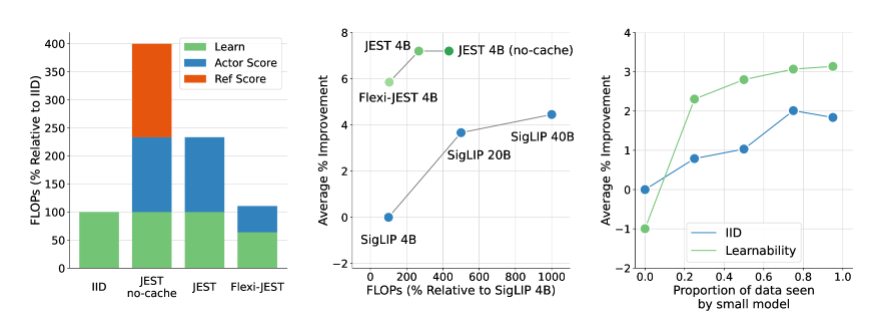

JEST方法的核心在於聯合選擇最佳數據批次,而非單個樣本,這一策略被證明在加速多模態學習方面尤爲有效。與傳統的大規模預訓練數據篩選方法相比,JEST不僅大幅減少了迭代次數和浮點運算次數,而且在僅使用10%的FLOP預算的情況下,就能超越以往的最先進水平。

DeepMind團隊的研究揭示了三個關鍵結論:選擇好的數據批次比單獨挑選數據點更有效,在線模型近似可以用於更高效地過濾數據,以及可以引導小型高質量數據集以利用更大的非精選數據集。這些發現爲JEST方法的高效性能提供了理論基礎。

JEST的工作原理,是通過借鑑之前關於RHO損失的研究,結合學習模型和預訓練參考模型的損失,評估數據點的可學習性。它選擇那些對於預訓練模型來說較容易,但對於當前學習模型來說較難的數據點,以此提高訓練效率和效果。

此外,JEST還採用了基於阻塞吉布斯採樣的迭代方法,逐步構建批次,每次迭代中根據條件可學習性評分選擇新的樣本子集。這種方法在過濾更多數據時持續改進,包括使用僅基於預訓練的參考模型來評分數據。

DeepMind的這項研究不僅爲AI訓練領域帶來了突破性進展,也爲未來的AI技術發展提供了新的思路和方法。隨着JEST方法的進一步優化和應用,我們有理由相信,人工智能的發展將迎來更加廣闊的前景。

論文:https://arxiv.org/abs/2406.17711

劃重點:

🚀 **訓練效率革命**:DeepMind的JEST方法使AI訓練時間減少13倍,算力需求降低90%。

🔍 **數據批次篩選**:JEST通過聯合選擇最佳數據批次,而非單個樣本,顯著提升了多模態學習的效率。

🛠️ **創新訓練方法**:JEST利用在線模型近似和高質量數據集引導,優化了大規模預訓練的數據分佈和模型泛化能力。