IBM 於五月份開源了適用於企業應用場景的 Granite13B LLM 模型。現在,IBM 的 AI 平臺產品副總裁阿曼德・魯伊茲(Armand Ruiz)公開了用於訓練 Granite13B 的全面6.48TB 數據集的完整內容。

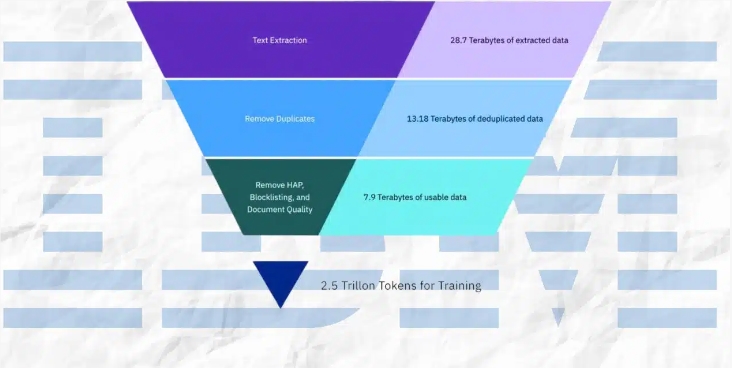

這個數據集經過嚴格的預處理後,縮減爲2.07TB,減少了68%。魯伊茲強調,這一步驟對於確保高質量、無偏見、符合倫理和法律的數據集,以滿足企業應用場景需求至關重要。

數據集由多個來源精心策劃而來,包括:

- arXiv:超過240萬篇科學論文預印本。

- Common Crawl:開放的網絡抓取數據庫。

- DeepMind Mathematics:數學問答對。

- Free Law:來自美國法院的公共領域法律意見。

- GitHub Clean:來自 CodeParrot 的代碼數據。

- Hacker News:2007-2018年的計算機科學和企業家新聞。

- OpenWeb Text:OpenAI 的 Web Text 語料庫的開源版本。

- Project Gutenberg(PG-19):專注於早期作品的免費電子書。

- Pubmed Central:生物醫學和生命科學論文。

- SEC Filings:美國證券交易委員會(SEC)的10-K/Q 提交文件(1934-2022年)。

- Stack Exchange:Stack Exchange 網絡上的用戶貢獻內容。

- USPTO:1975年至2023年5月間授予的美國專利。

- Webhose:將非結構化網絡內容轉換爲機器可讀數據。

- Wikimedia:八個英文維基媒體項目。

預處理流程包括文本提取、去重、語言識別、句子分割、仇恨、濫用和粗話標註、文檔質量標註、URL 屏蔽標註、過濾和標記化。

這些步驟涉及基於設定閾值的標註和過濾,確保最終數據集對模型訓練具有最高質量。

IBM 發佈了 Granite 代碼模型的四個版本,參數範圍從30億到340億。這些模型已在一系列基準測試中進行了測試,並在許多任務中勝過其他可比模型,如 Code Llama 和 Llama3。

劃重點:

⭐ IBM 發佈了用於訓練 Granite13B LLM 模的完整6.48TB 數據集。

⭐ 數據集經過嚴格的預處理後,縮減爲2.07TB,減少了68%。

⭐ IBM 發佈了四個 Granite 代碼模型的版本,參數範圍從30億到340億。