法國獨立非盈利AI研究實驗室 Kyutai 發佈了一款語音助理 Moshi,這是一款革命性的實時本機多模態基礎模型。這一創新模型在某些功能上模仿並超越了 OpenAI 在五月推出的 GPT-4o 所展示的一些功能。

產品入口:https://top.aibase.com/tool/moshi-chat

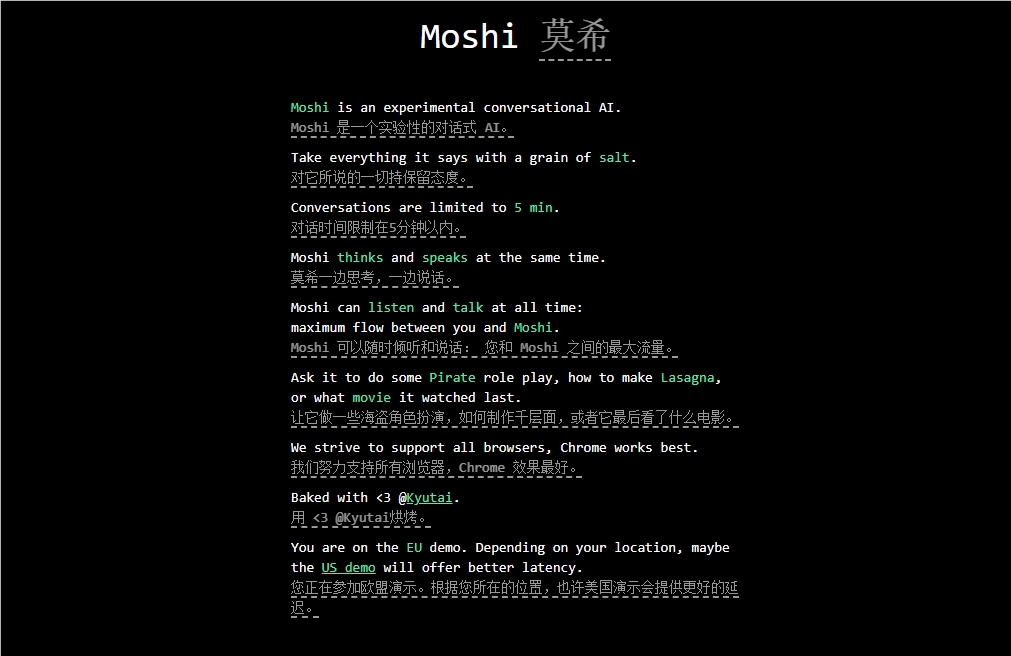

Moshi 旨在理解和表達情感,具備使用不同口音(包括法語)進行對話的能力。它可以同時聽和生成音頻和語音,並保持文本思維的流暢傳達。據瞭解,Moshi具有多種類似人類的情緒,能夠帶着70種情緒和風格講話。

Moshi 的一個突出特點是可以同時處理兩個音頻流,使其能夠同時聽和說話。這種實時互動是基於對混合文本和音頻進行聯合預訓練而實現的,利用了 Kyutai 開發的70億參數語言模型 Helium 的合成文本數據。

Moshi 的微調過程涉及了通過文本轉語音(TTS)技術轉換的10萬個 “口語風格” 合成對話。該模型的聲音是通過另一個 TTS 模型生成的合成數據進行訓練的,實現了驚人的端到端延遲時間爲200毫秒。

值得注意的是,Kyutai 還開發了 Moshi 的一個較小變體,可以在 MacBook 或消費者級 GPU 上運行,使更廣泛範圍的用戶可以使用。

劃重點: 🔍 Kyutai 發佈了 Moshi,一款實時原生多模態基礎 AI 模型。

🔍 Moshi 具備理解和表達情感的功能,支持多種口音。

🔍 該模型經過嚴格的微調和訓練,展示出高效性能和多樣化應用潛力。