360智腦團隊宣佈推出全新的Light-IF系列模型,這一創新框架旨在顯著提升大型語言模型(LLM)在複雜指令遵循方面的能力。隨着人工智能技術的不斷進步,儘管LLM在數學、編程等領域已經展現出了卓越的推理能力,但在遵循複雜指令方面仍存在不足。爲了解決這一問題,360智腦團隊提出了以預覽-自檢式推理和信息熵控制爲核心的Light-IF框架。

Light-IF框架通過五個關鍵環節來提升模型性能:難度感知指令生成、Zero-RL強化學習、推理模式提取與過濾、熵保持監督冷啓動、熵自適應正則強化學習。這一框架的提出,旨在破解當前推理模型中存在的“懶惰推理”現象,即模型在思考階段僅複述指令而不主動檢查約束是否被滿足,導致指令執行不準確的問題。

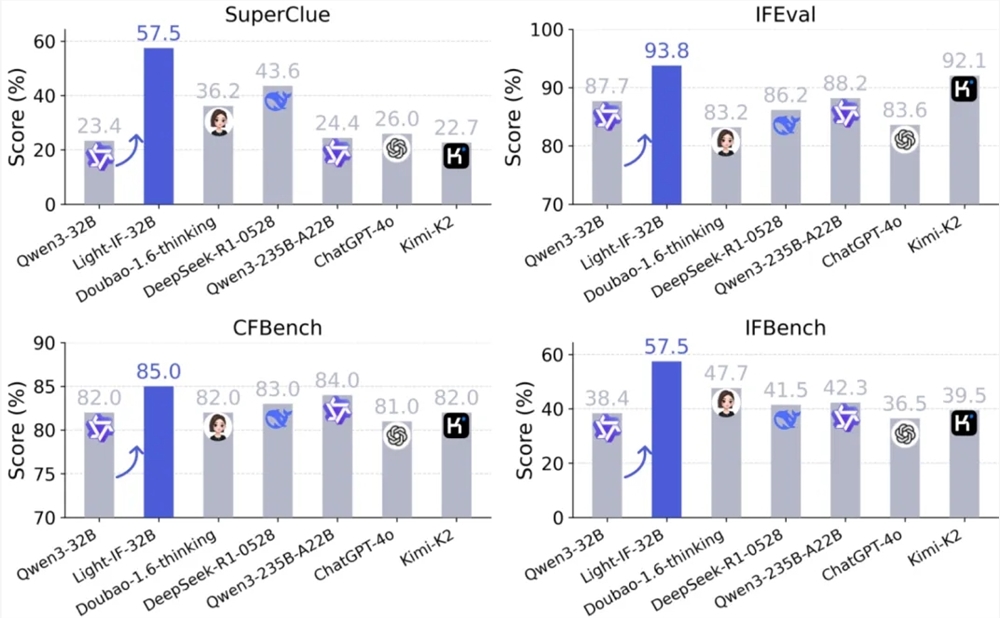

在實驗中,Light-IF系列模型在SuperCLUE、IFEval、CFBench及IFBench四個中文和跨語言指令遵循基準上均取得了顯著提升。特別是32B版本的Light-IF-32B,其在SuperClue得分達到了0.575,比下一個最佳模型高出13.9個百分點。此外,參數規模僅爲1.7B的Light-IF-1.7B在SuperClue和IFEval上的表現甚至超過了Qwen3-235B-A22B等體量更大的模型。

360智腦團隊表示,Light-IF系列模型的推出,不僅爲開源社區提供了一套可復現的完整路線和配套的開源代碼,而且全系模型將陸續在Hugging Face上開放,供社區使用、對比與復現。同時,訓練中使用的冷啓動數據集也將同步在GitHub上開放。此外,360與SuperCLUE聯合推出的中文精確指令遵循測評基準SuperCLUE-CPIFOpen也將在Github上開放,便於研究者評測模型的中文精確指令遵循能力。

這一新模型的推出,標誌着360智腦在提升人工智能模型複雜指令遵循能力方面邁出了重要一步,爲人工智能技術的發展和應用開闢了新的可能性。