昨夜、1024×1024のネオン着物の写真がRTX4090でわずか2.3秒でレンダリングされ、VRAMポインタは安定して13GBに保たれた――アリババ・トングイラボが公開したZ-Image-Turboにより、周囲の注目は一瞬で静まり返った。パラメータ数は6Bのみだが、20B以上の閉鎖型トップモデルと同等の性能を達成し、一部では優位を維持している。

華美なスローガンはなく、Z-Imageは実績で語る。

- 8ステップのサンプリングで印刷品質の画質を提供可能。エントリーレベルのGPUである3060 6Gでも動作可能。VRAM容量は最大16G;

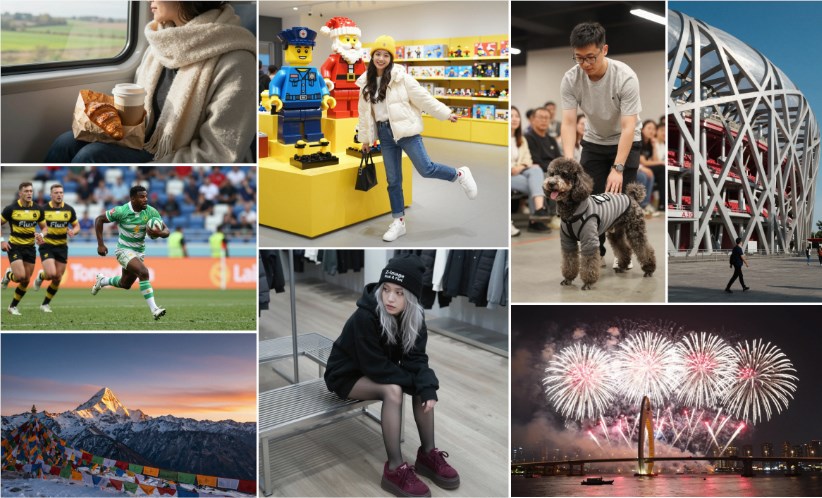

- 長い中国語のプロンプトを一度に理解可能。例えば「夜の太陽」や「左手にチヤー、右手にスマートフォン画面に今日のニュース」といった表現も自動的に修正され、中英文字母も乱れなくなる。

- 皮膚の毛穴、ガラスの反射、雨や霧の逆光、映画のような焦点深度などがすべてオンラインで処理可能。Elo人工的好みランキングではZ-Image-Turboがオープンソース界の最上位グループにランクインした。

その秘密は新開発のS3-DiTアーキテクチャにある。テキスト、視覚的な意味、画像トークンが単一流に結合され、パラメータ数は競合の1/3に削減され、推論効率は最大限まで引き上げられている。チームはついでにZ-Image-Editも公開しており、自然言語で1文で元の画像の「顔替えや風景変更」が可能となり、コミュニティユーザーは即座に遊ぶことができる。

アリババはまだ完全オープンソースするかどうかを公式発表していないが、モデルはすでにModelScopeおよびHugging Faceにアップロードされており、pull requestはdiffusersのメインブランチにマージされている。pipコマンド1行で読み込むことが可能だ。企業版APIの価格が発表されれば、MidjourneyやFluxたちも早めに価格引き下げを考える必要があるかもしれない。

Z-Imageの登場はスタートピストルのようだった。画像生成のレースは本格的に「軽量かつ高品質」の時代に入った。計算力の民主化はただのスローガンではなくなり――誰のGPUにも16GBはあるだろう。

プロジェクトアドレス:https://github.com/Tongyi-MAI/Z-Image