最近、ジョンズ・ホプキンス大学は「EGO-Prompt」というフレームワークをリリースしました。このフレームワークは、専門分野のタスクにおける小さな言語モデルの性能を大幅に向上させ、性能は約50%向上し、コストは83%削減されました。この革新的なフレームワークは主に専門分野のタスク、例えば医療診断や交通管理などに使用され、小さなAIモデルが大規模な推論モデルと同等の性能を持つことを可能にしています。

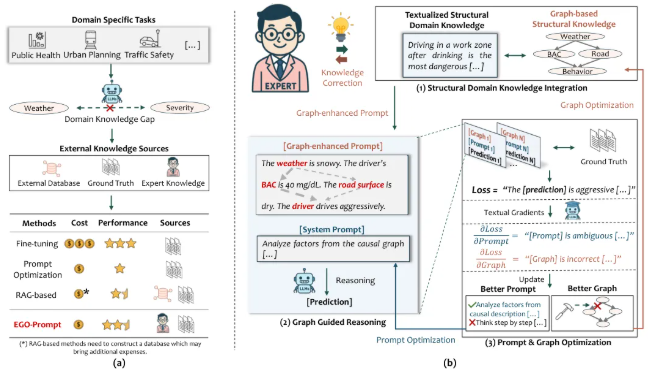

実際の応用において、適切なプロンプトを作成することは課題であり、専門分野の知識を組み込みつつ、AIが効果的に推論し、重要な情報を抽出できるようにする必要があります。EGO-Promptフレームワークの核となるのは、最適化されたプロンプトを自動生成し、因果論理を組み合わせてAIに人間のように段階的に考える能力を提供することです。

このフレームワークは、専門家が提供する簡単なプロンプトと因果関係図から始まり、自動最適化を通じて具体的な推論ガイドを生成し、AIの思考をより明確にします。このプロセスでは、現実データを繰り返し使用して因果図とプロンプトを調整し、最適な結果を得るまで続けます。また、EGO-Promptはモデルの説明性を向上させ、ユーザーがAIの判断根拠を簡単に理解できるようにします。

従来の最高の方法と比較すると、EGO-PromptのF1スコアは平均で7.32%〜12.61%向上しています。このフレームワークを使用した小さなAIモデルは、元のコストの20%以下のコストで、大規模なAIモデルと同等の性能を達成できます。このような動的な知識進化の仕組みにより、専門家の知識は静的なものではなく、モデルと共に成長していくことができます。

EGO-Promptの革新点は、専門家の知識を静的なマップから意味的因果図(Semantic Causal Graph, SCG)に変換し、初期の図に多少の不完全さがあっても許容することです。このようなエラー対応設計により、最適化プロセスがより柔軟になり、AIが生成中に起こりうる意味のずれを避けることができます。

EGO-Promptは、精巧な2段階の推論メカニズムを採用しており、推論プロセスを指導生成と条件推論の2つのステップに分解することで、モデルの認知負荷を大きく軽減し、複雑な専門分野のデータを処理する際により効率的になります。

github:https://github.com/miemieyanga/EGO-Prompt

ポイント:

- 🚀 EGO-Promptフレームワークにより、小さなAIモデルの性能は約50%向上し、コストは83%削減されます。

- 📊 新しい方法は、プロンプトと因果論理を自動最適化することで、AIの推論能力を向上させます。

- 🧠 意味的因果図を採用し、初期の知識図に多少の不完全さがあっても許容することで、知識の動的な進化を推進します。