今日は、テンセントが混元世界モデル1.1(WorldMirror)を正式にリリースし、オープンソース化しました。この新しいバージョンは、マルチビューや動画入力のサポート、単一カードでのデプロイ、生成速度などにおいて大幅なアップグレードを行い、3D再構築技術の普及と応用に新たな扉を開きました。

混元世界モデル1.1は、強力な機能を持ち、専門的な3D再構築技術を一般ユーザーが簡単に使用できるツールにするために設計されています。このモデルは数秒で動画や画像からプロフェッショナルな3Dシーンを生成でき、3D再構築の効率と使いやすさを大幅に向上させました。前バージョンである混元世界モデル1.0は今年7月にリリースされ、業界初の伝統的なCGパイプラインに対応したオープンソースの歩行可能な世界生成モデルとなりました。新バージョンでは、マルチモーダル事前知識の注入とマルチタスク統一出力のエンド・トゥ・エンドの3D再構築が実現されました。

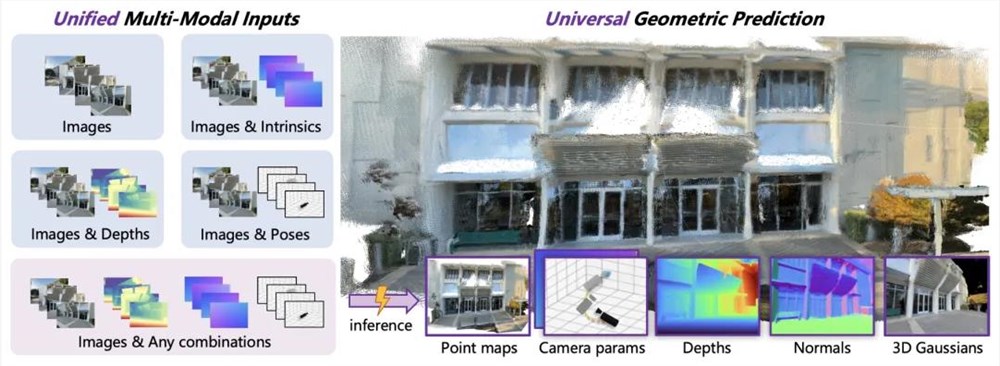

このモデルの3つの主要な特徴には、異なる入力を柔軟に処理すること、一般的な3D視覚予測、および単一カードでの秒単位の推論があります。混元世界モデル1.1はマルチモーダル事前知識ガイドメカニズムを採用しており、カメラポーズ、カメラ内パラメータ、深度マップなどの情報を注入することが可能で、生成された3Dシーンが幾何学的により正確になります。同時に、ポイントクラウド、深度マップ、カメラパラメータ、表面法線、新しいビュー合成などの多様な3Dジオメトリ予測を実現し、顕著な性能上の優位性を示しています。

従来の3D再構築方法と比較して、混元世界モデル1.1は純粋なフォワードアーキテクチャを使用しており、一度のフォワードパスですべての3D属性を直接出力することができ、処理時間を顕著に短縮します。典型的な8〜32ビュー入力の場合、モデルはわずか1秒で推論を完了し、リアルタイムアプリケーションのニーズを満たします。

技術アーキテクチャに関しては、混元世界モデル1.1はマルチモーダル事前知識のヒントと一般的な幾何予測アーキテクチャを採用し、コース学習戦略を組み合わせることで、複雑な現実環境でも効率的かつ正確な解析能力を維持しています。動的インジェクションメカニズムにより、モデルはさまざまな事前知識に柔軟に対応し、3D構造の一貫性と再構築品質を向上させています。

現在、混元世界モデル1.1はGitHub上でオープンソース化されており、開発者は簡単にリポジトリをクローンし、ローカルにデプロイできます。また、一般ユーザーはHuggingFace Spaceを通じてオンラインで体験でき、複数のビュー画像や動画をアップロードし、リアルタイムで生成された3Dシーンをプレビューできます。この技術のリリースは、3D再構築分野における重要な進展を示しており、今後仮想現実やゲーム開発などの業界をさらに促進していくことになります。

プロジェクトホーム:https://3d-models.hunyuan.tencent.com/world/

Githubプロジェクトアドレス:https://github.com/Tencent-Hunyuan/HunyuanWorld-Mirror

Hugging Faceモデルアドレス:https://huggingface.co/tencent/HunyuanWorld-Mirror