近年、大規模言語モデル(LLM)の急速な発展により、人工知能技術の境界が広がり、特にオープンソース分野において、モデルアーキテクチャのイノベーションが業界の注目を集めています。AIbaseは最近のインターネット情報を取りまとめ、Llama3.2、Qwen3-4B、SmolLM3-3B、DeepSeek-V3、Qwen3-235B-A22BおよびKimi-K2などの主要なオープンソース大規模モデルのアーキテクチャの特徴と技術的違いを詳細に分析し、読者に2025年のLLM分野における最新の技術トレンドを紹介しています。

MoEアーキテクチャの台頭:DeepSeek-V3とQwen3の競争

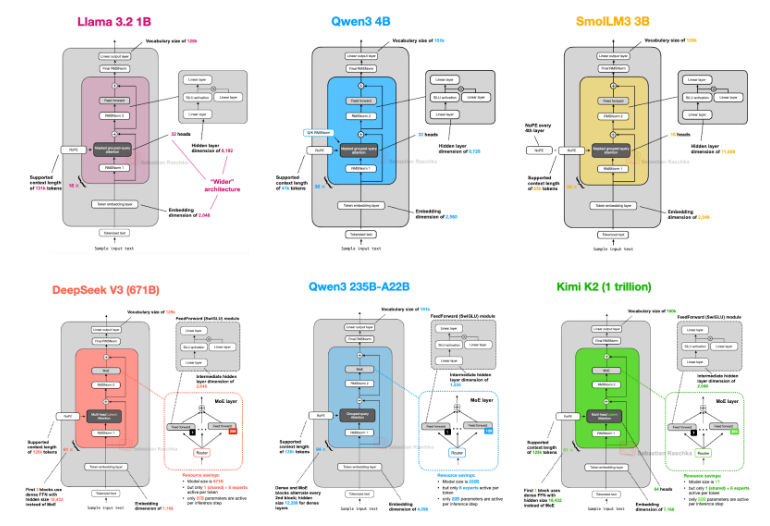

2025年のオープンソース大規模モデル分野において、混合専門家モデル(MoE)が技術革新のホットスポットとなっています。DeepSeek-V3は、合計パラメータ数6710億個で、活性化パラメータ数370億個のMoEアーキテクチャで注目されています。その特徴は、Transformerレイヤーのうち最初の3つを除き、すべてのレイヤーにMoEレイヤーを使用し、9つのアクティブエキスパート(各エキスパートの隠れ層サイズ2048)を備え、トレーニングの安定性を向上させるための共有エキスパートを保持しています。一方、Qwen3-235B-A22Bも同様にMoEアーキテクチャを採用しており、合計パラメータ数2350億個で、活性化パラメータ数220億個を持ちます。ただし、このモデルでは共有エキスパートを採用せず、Qwen2.5-MoEの2つのエキスパートから大幅に増加した8つのエキスパートを採用しています。AIbaseは、Qwen3チームが共有エキスパートを廃止した理由を明確には公表していませんが、8つのエキスパート構成においてトレーニングの安定性が十分であると考えられ、追加の計算コストを回避するための選択であると推測しています。

DeepSeek-V3とQwen3-235B-A22Bのアーキテクチャは非常に似ており、開発チームがパフォーマンスと効率のバランスを取る上で異なる考えを持っていることが示されています。例えば、DeepSeek-V3は推理速度が優れており、約50トークン/秒ですが、Qwen3は出力の構造化能力に長けており、特にコード作成や数学タスクで優れた性能を発揮します。これは、MoEアーキテクチャの柔軟性が開発者にとってタスクに応じてモデルを最適化できる可能性を提供していることを示しています。

中小規模モデルの突破:SmolLM3-3BとQwen3-4B

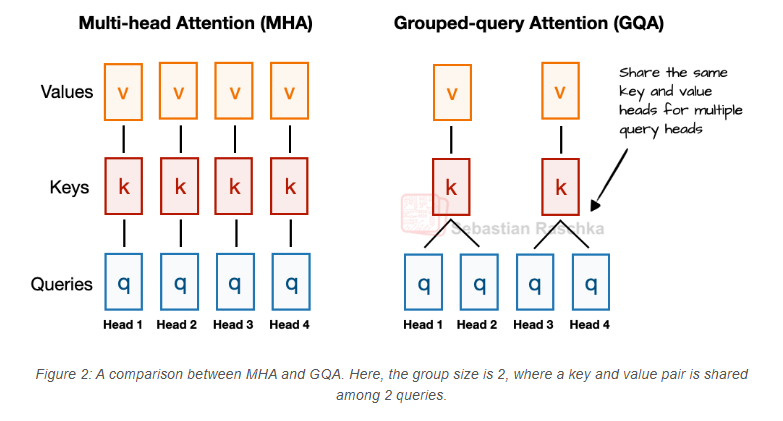

中小規模モデルの分野において、SmolLM3-3BとQwen3-4Bはその高いパフォーマンスで注目されています。SmolLM3-3Bはデコーダー型のTransformerアーキテクチャを採用し、グループクエリーアテンション(GQA)と位置情報なし符号化(NoPE)設計を備えており、予訓練データ量は11.2兆トークンに達し、ネットワーク、コード、数学、推論データをカバーしています。独自のNoPE設計は2023年の研究に基づいており、従来の位置符号化(例:RoPE)を除去することで、長文の一般化能力を向上させることを目的としています。SmolLM3-3Bは、Qwen3-1.7Bと4Bの間のパラメータ数を持つものの、3B-4B規模のモデルの中で特に優れたパフォーマンスを発揮しており、特に6言語の多言語サポートや長文処理において顕著です。

Qwen3-4Bは、32,768トークンのコンテキスト長さと36層のTransformerアーキテクチャを備え、軽量な配置での強力な潜在能力を示しています。Qwen3-4Bは約36兆トークンのデータセットを予訓練に使用し(Qwen2.5よりも倍増)、4段階のトレーニングパイプラインにより、推論とコード作成能力を最適化しました。AIbaseは、Qwen3-4BがSTEM、コード作成、推論タスクにおいて、より多くのパラメータを持つQwen2.5モデルを上回っていることを観察し、中小規模モデルが効率とパフォーマンスにおいて大きな潜在能力を持っていることを示しています。

Llama3.2とKimi-K2:古典と革新の衝突

Llama3.2(3Bパラメータ)はMeta AIの古典的なデザインを引き継ぎ、モードと密接な層を交互に使用する混合アーキテクチャを採用しています。2つのアクティブエキスパート(各エキスパートの隠れ層サイズ8192)を備えています。DeepSeek-V3の9つのエキスパート設計と比較すると、Llama3.2はエキスパートの数が少ないものの、規模が大きく、計算リソースの配分に関して保守的な戦略を採用しています。AIbaseは、Llama3.2が情報検索や創造的な執筆タスクにおいて優れた性能を発揮していることに気づきましたが、複雑な推論タスクではQwen3やDeepSeek-V3に劣っていることを指摘しています。

Kimi-K2は、総パラメータ数1兆個と、活性化パラメータ数320億個を持つMoEアーキテクチャによってオープンソース分野の「巨無霸」として注目されています。自主的なプログラミング、ツール呼び出し、数学的推論タスクにおいて優れた性能を発揮し、一部の指標ではDeepSeek-V3を上回っています。Kimi-K2のオープンソース戦略(Apache2.0ライセンス)により、開発者と研究者から人気がありますが、ハードウェア要件が高いため、部署には注意が必要です。AIbaseは、Kimi-K2の登場がMoEアーキテクチャが大規模モデルにおいてさらに活用されるきっかけとなり、オープンソースLLMがより高性能かつ低コストな推論に向かうことを示していると考えています。

技術トレンドと今後の展望

AIbaseは、2025年のオープンソースLLMが以下のトレンドを示していると分析しています。第一に、MoEアーキテクチャは、効率的なパラメータ利用率と推論速度の利点により、伝統的な密集モデルを置き換える傾向にあります。第二に、中小規模モデルはトレーニングデータとアーキテクチャの最適化を通じて、大型モデルに近い性能を実現しています。第三に、NoPEや長文処理能力の向上などのイノベーション技術が、LLMのマルチモーダルおよびマルチ言語応用を促進しています。

各モデルのアーキテクチャに微細な違いがあるものの、例えばエキスパート数、位置符号化方式、トレーニングデータの規模など、それらの違いが最終的なパフォーマンスに与える影響はまださらなる研究が必要です。AIbaseは、開発者がモデルを選択する際には、具体的なタスクのニーズに基づいてパフォーマンス、推論コスト、および配置の難易度を考慮すべきだと提案しています。たとえば、推論速度を重視するユーザーはDeepSeek-V3を選ぶのが良いかもしれませんが、出力品質と多タスク能力を重視するユーザーはQwen3-235B-A22Bを優先的に選ぶべきです。

オープンソースLLMの黄金時代

Llama3.2の堅実な設計からKimi-K2の極限的なMoEアーキテクチャまで、オープンソース大規模モデルは2025年に技術と応用の両方で大きな突破を遂げました。AIbaseは、オープンソースコミュニティの継続的な貢献とハードウェア技術の進歩により、LLMのアーキテクチャ革新がAI開発の障壁をさらに低下させ、世界中のユーザーに多くのスマートソリューションを提供することになると信じています。今後もAIbaseはオープンソースLLMの最新進展を追跡し、読者に最先端の洞察を提供し続けます。