このたび、騰訊クラウドの公式ウェブサイトでは、騰訊・ホンイェンA13BモデルのAPIサービスが正式にリリースされ、入力料金は100万トークンあたり0.5元、出力料金は100万トークンあたり2元と設定されました。この取り組みは開発者コミュニティで大きな反響を呼びました。

業界で初めて13B規模のMoE(混合専門家)オープンソース混合推論モデルとして、Hunyuan-A13Bは総パラメータ数80B、アクティブパラメータ数がわずか13Bという簡潔な設計により、同等のアーキテクチャを持つ先進的なオープンソースモデルと同等の性能を実現し、さらに推論速度が優れているため、コストパフォーマンスが大幅に向上しました。この革新は、開発者が先進的なモデルの能力にアクセスするハードルを下げ、AIアプリケーションの広範な普及に堅固な基盤を築くことに貢献しています。

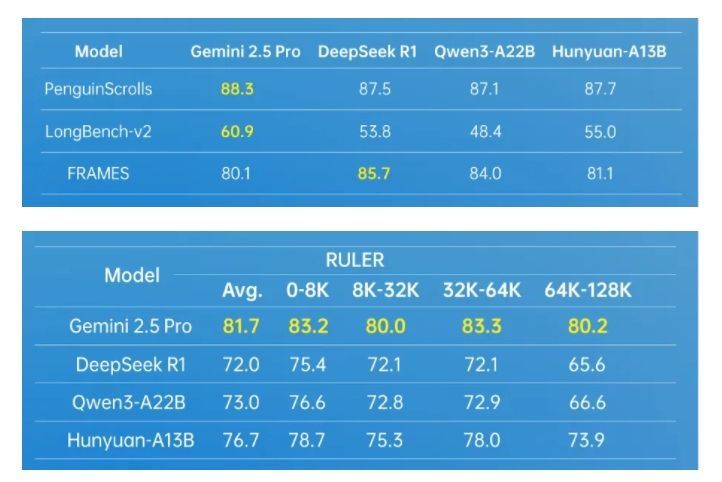

Hunyuan-A13Bモデルは、高度なアーキテクチャ設計により、強力な汎用性を備えています。複数の業界で権威あるデータテストセットにおいて、優れた成績を収めています。特にエージェントツールの呼び出しや長文処理において突出しています。さらにエージェント能力を向上させるために、騰訊・ホンイェンチームは多エージェントデータ合成フレームワークを構築し、MCP、サンドボックス、大規模言語モデルのシミュレーションなどの多様な環境に接続し、強化学習技術を活用してエージェントがさまざまな環境で自主的に探索と学習を行うことで、モデルの実用性と効果を顕著に向上させました。

長文処理において、Hunyuan-A13Bは256Kのネイティブなコンテキストウィンドウをサポートしており、複数の長文データセットにおいて優れたパフォーマンスを維持しています。また、このモデルは、タスクのニーズに応じて「速い思考」と「遅い思考」のモードを自由に切り替えることが可能な統合推論モードを独自に導入しており、出力効率を保ちつつ特定のタスクの正確性も確保し、計算リソースの最適な配分を実現しています。

個人開発者にとっても、Hunyuan-A13Bモデルは非常に使いやすく、厳しい条件下でも中低性能GPUカード1枚でデプロイ可能です。現在、このモデルはオープンソースの主流推論フレームワークエコシステムにスムーズに統合されており、さまざまな量子化形式をサポートしており、同じ入出力規模において、全体的なスループットは最先端のオープンソースモデルの2倍以上であり、その優れたパフォーマンスと柔軟性を示しています。

Hunyuan-A13Bモデルの成功は、騰訊・ホンイェンチームがモデルの事前トレーニングおよび後訓練の段階で採用した革新技術に支えられています。事前トレーニングの段階では、20Tトークンに達する語彙データベースをトレーニングし、複数の分野をカバーし、モデルの汎用性を大幅に向上させました。同時に、体系的な分析とモデル検証を通じて、MoEアーキテクチャ向けのScaling Lawの結合式を構築し、MoEアーキテクチャ設計に量化可能なエンジニアリング指針を提供しました。後訓練の段階では、複数段階のトレーニング方式を採用し、モデルの推論能力と汎用性をさらに向上させました。

騰訊内部で最も多く使用され、呼び出されている大規模言語モデルの一つとして、Hunyuan-A13Bは400以上のビジネスシーンに広く適用されており、日平均リクエスト数は1億3,000万件を超え、実際のアプリケーションにおける価値と安定性を十分に証明しています。

https://cloud.tencent.com/product/tclm