AI技術が急速に発展する現代において、私たちは多くの驚くべきイノベーションを目の当たりにしています。最近SNSで話題の「Diffree」もその一つです。これは新しいスマホゲームではなく、デザイナーや写真家たちが歓喜するAI画像処理技術なのです。

テキストの説明に基づいて、画像に「痕跡なく」新しい物体を追加できます。「透明マント」を手に入れたようなものです。手動でマスクやテンプレートを追加する必要はなく、モデルが自動的にオブジェクトの位置と形状を予測し、シームレスに融合して新しいオブジェクトを追加します。

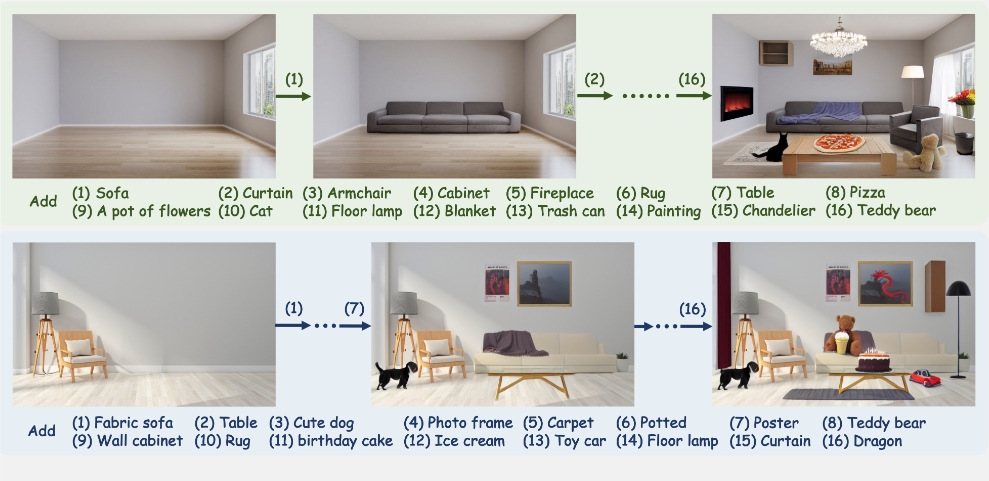

例えば、インテリアデザイナーが顧客に様々な装飾品の効果を提示する場合を考えてみましょう。以前は、手動で画像を編集したり、再撮影する必要がありましたが、今ではDiffreeに要望を伝えるだけで、写真に新しい装飾品を「気付かれずに」追加でき、違和感なく仕上がります。

この技術の中核は「テキスト誘導」機能です。「ソファにクッションを置く」といった簡単なテキストの説明を入力するだけで、Diffreeはあなたの要望を理解し、ソファの上にクッションを「出現」させます。しかも、光、色調、色は元の画像と一致しています。

では、Diffreeはどのように実現しているのでしょうか?それは、「テキストから画像へ」(T2I)モデルによるものです。このモデルは訓練を通して、テキストの説明に基づいて画像コンテンツを生成する方法を学習しています。Diffreeは「Stable Diffusion」と呼ばれる拡散モデルを使用し、追加のマスク予測モジュールによって新しいオブジェクトの最適な位置を予測します。

Diffreeが現実世界をより良く理解できるように、研究者たちは「OABench」という合成データセットを作成しました。このデータセットには、74,000個の現実世界の画像とテキストのペアが含まれており、これらを使用してDiffreeを訓練し、画像に物体を正確に追加しながら、背景の一貫性を維持できるようにしています。

Diffreeの能力はそれだけではありません。単一のオブジェクトを追加するだけでなく、同じ画像に複数の異なるオブジェクトを同時に追加でき、毎回背景の一貫性を維持できます。まるで高度な「間違い探し」ゲームをしているようで、AIが背景を変えることなく巧みに新しい要素を追加します。

研究者たちは一連の実験を通じてDiffreeの優位性を証明しました。成功率、オブジェクトの妥当性、品質、多様性、関連性のいずれにおいても、Diffreeはテキスト誘導やマスク誘導に基づく他の技術をはるかに凌駕しています。

Diffreeの登場は、単なる技術の飛躍ではなく、デザイナー、写真家、さらには一般ユーザーにとっても朗報です。画像編集のハードルを下げ、誰もがクリエイターになれる時代が到来しました。将来のDiffreeは、他のAI技術と連携し、さらに驚くべきアプリケーションシナリオを開拓する可能性を秘めています。

プロジェクトアドレス:https://top.aibase.com/tool/diffree