Meta AIの研究者Thomas Scialom氏は最近のインタビューで、最新のプロジェクトLlama3に関する見解を共有しました。同氏は、インターネット上の膨大なテキストデータの質にばらつきがあることを率直に指摘し、そのようなデータを用いたトレーニングは資源の無駄だと考えています。そのため、Llama3のトレーニングでは、人間が作成した回答は一切使用せず、Llama2によって生成された合成データのみを使用しました。

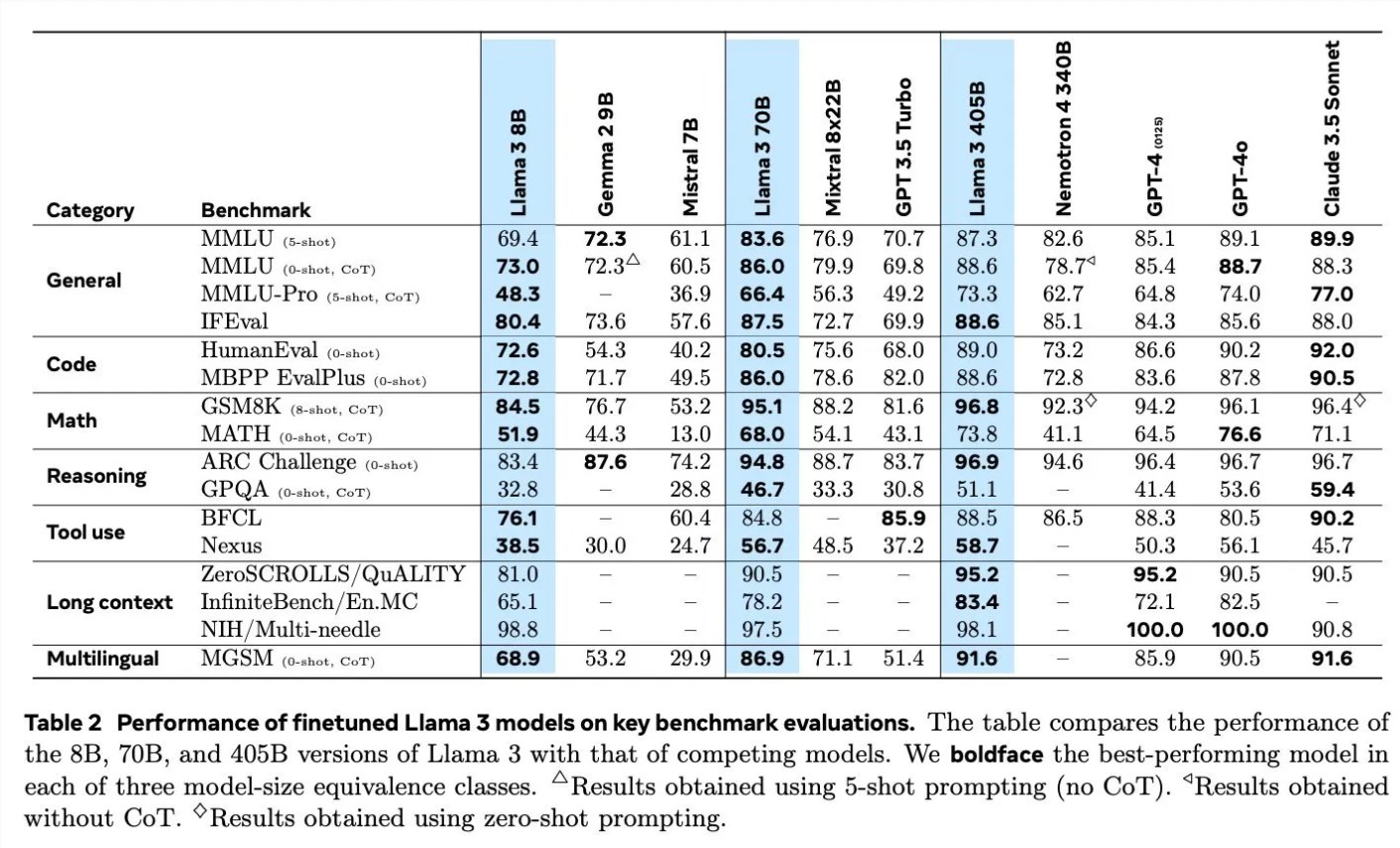

Llama3のトレーニングの詳細について議論する中で、Scialom氏は合成データの様々な分野への応用について詳しく説明しました。例えば、コード生成においては、コード実行のフィードバック、プログラミング言語の翻訳、ドキュメントの逆翻訳という3つの異なる方法で合成データを作成しました。数学的推論においては、「段階的に検証しよう」という研究手法を取り入れました。さらに、Llama3は90%以上の多言語トークンを用いて事前学習を継続し、高品質な人間の注釈を収集しました。これは多言語処理において特に重要です。

長文処理もLlama3の重点事項であり、合成データを用いて長文の質問応答、長文書の要約、コードベースの推論を行いました。ツール利用の面では、Brave検索、Wolfram Alpha、Pythonインタープリターを用いて、単一、ネスト、並列、多回転の関数呼び出しを実現しました。

Scialom氏はまた、強化学習と人間のフィードバック(RLHF)がLlama3のトレーニングにおいて重要な役割を果たしたことを述べました。彼らは人間の好みデータを利用してモデルをトレーニングし、ゼロから創作するのではなく、(例えば2つの詩からより良い方を選ぶなど)選択を行う上での人間の能力を強調しました。

Metaは6月にLlama4のトレーニングを開始しており、Scialom氏によると、Llama4の主要な焦点はエージェント(智能体)を中心としたものになるということです。さらに、より多くのパラメータを持つ多様なモダリティに対応したLlamaについても言及し、近いうちに公開する予定であると述べました。

Scialom氏のインタビューは、Meta AIの人工知能分野における最新の進歩と将来の方向性、特に合成データと人間のフィードバックをどのように活用してモデルの性能を向上させるかを示しています。