最近、アップル社の研究チームとMeta AIの研究者らが共同で、大規模言語モデル(LLM)の長文推論における効率性を向上させる「LazyLLM」という新技術を発表しました。

ご存じのとおり、現在のLLMは長いプロンプト処理、特にプリフィリング段階で速度が遅いという問題を抱えています。これは、最新のトランスフォーマーアーキテクチャが計算注意力において、プロンプト内のトークン数に比例して計算量が二乗で増加するためです。そのため、Llama2モデルを使用する場合、最初のトークンの計算時間は後続のデコードステップの21倍にもなり、生成時間の23%を占めています。

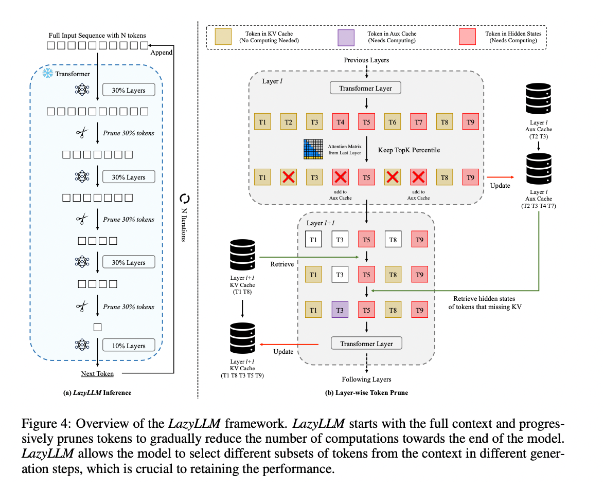

この状況を改善するために、研究者らはLazyLLMを提案しました。これは、重要なトークンの計算を選択的に行うことでLLM推論を高速化する新しい手法です。LazyLLMの中核は、前の層の注意力スコアに基づいて各トークンの重要性を評価し、計算量を段階的に削減することです。永続的な圧縮とは異なり、LazyLLMは必要に応じて削減されたトークンを復元し、モデルの精度を確保します。さらに、LazyLLMはAux Cacheと呼ばれるメカニズムを導入し、剪定されたトークンの隠れ状態を保存することで、これらのトークンを効率的に復元し、性能低下を防ぎます。

LazyLLMは推論速度において優れた性能を示し、特にプリフィリングとデコード段階で顕著です。この技術の3つの主な利点は、あらゆるトランスフォーマーベースのLLMと互換性があり、モデルの再トレーニングが不要で、多様な言語タスクで非常に効果的であることです。LazyLLMの動的剪定戦略により、重要なトークンの大部分を維持しながら、計算量を大幅に削減し、生成速度を向上させることができます。

研究結果によると、LazyLLMは複数の言語タスクで優れた性能を示し、TTFT速度はLlama2で2.89倍、XGenで4.77倍向上し、精度はほぼベースラインと同等でした。質問応答、要約生成、コード補完タスクなど、LazyLLMはより高速な生成速度を実現し、性能と速度のバランスを良好に保っています。漸進的な剪定戦略と層ごとの分析が、LazyLLMの成功の基礎となっています。

論文アドレス:https://arxiv.org/abs/2407.14057

要点:

🌟 LazyLLMは重要なトークンを動的に選択することで、LLM推論プロセスを高速化し、特に長文のシナリオで優れた性能を発揮します。

⚡ この技術は推論速度を大幅に向上させ、TTFT速度は最大4.77倍向上し、高い精度を維持します。

🔧 LazyLLMは既存のモデルに変更を加える必要がなく、あらゆるトランスフォーマーベースのLLMと互換性があり、実装が容易です。