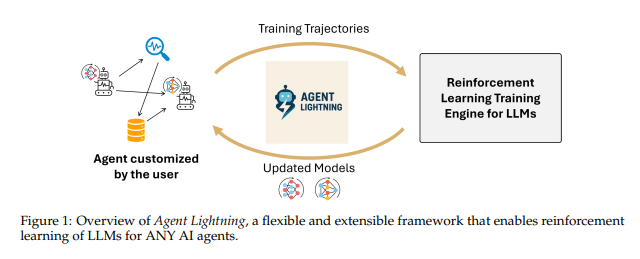

微软研究院推出一款名为Agent Lightning的全新强化学习训练框架,旨在解决当前AI代理系统训练过程中面临的通用性和灵活性挑战。该框架通过创新的解耦设计,能够对不同架构的AI代理进行统一的强化学习训练。

当前AI大语言模型虽然在代码编写、内容创作等任务上表现出色,但在面对复杂的多轮对话、专业领域数据处理或陌生工具使用时仍存在局限性。如何让这些模型在真实环境中持续学习和改进,成为AI研究领域的重要课题。

传统的监督学习方法需要大量标注数据,对于复杂的交互式任务而言成本高昂且耗时。强化学习作为替代方案,通过奖励和惩罚机制让AI系统在试错中学习,更适合让大模型在真实环境反馈中进行优化。

论文地址:https://arxiv.org/pdf/2508.03680

然而,现有强化学习框架主要针对单次任务设计,难以适应AI代理需要进行多轮对话、调用外部工具、执行复杂任务流的特点。不同AI代理的架构差异也使得通用化训练变得困难。

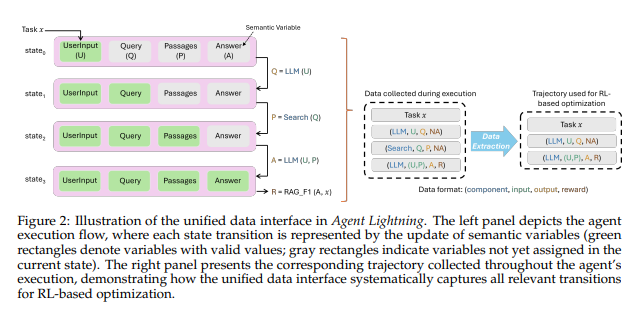

Agent Lightning的核心创新在于采用解耦设计思路,将AI代理的执行过程与强化学习的训练过程完全分离。该框架将AI代理的执行过程抽象为马尔可夫决策过程(MDP),通过状态、动作和奖励的循环来描述代理行为。

在这一设计中,状态代表AI代理在特定时刻的运行状态,动作对应大语言模型的文本输出,奖励则是对动作效果的评分。通过这种抽象,无论AI代理基于LangChain、OpenAI Agents SDK、AutoGen等任何框架构建,其执行过程都可以转换为统一的数据接口格式。

为优化训练效果,Agent Lightning配套开发了LightningRL分层强化学习算法。该算法能够将任务整体奖励合理分配给轨迹中的每个动作步骤,使大模型能够明确了解每一步操作的效果,从而实现更高效的学习。

系统架构方面,Agent Lightning采用"训练-代理分离"设计,包含Agent Lightning Server和Agent Lightning Client两个核心组件。服务器负责管理强化学习训练流程和模型参数优化,客户端负责运行代理、收集数据并与服务器通信。这种架构设计实现了训练过程和代理运行的完全解耦。

在实际测试中,Agent Lightning在多个场景下展现出良好性能。在文本转SQL任务中,通过LangChain构建的多代理系统实现了持续稳定的性能提升。在RAG(检索增强生成)任务中,基于OpenAI Agents SDK的代理在复杂开放式问答中表现出持续改进。在数学问答任务中,AutoGen构建的数学代理学会了有效调用计算器工具进行精确计算。

Agent Lightning的推出为AI代理训练领域提供了新的技术路径。其通用性设计使得任何架构的AI代理都可以在不修改代码的前提下接受训练。灵活的架构支持多代理协作、动态流程和复杂工具调用等各种应用场景。分布式设计则为大规模训练提供了可扩展性支持。

从技术发展角度来看,Agent Lightning代表了AI代理训练技术向标准化和模块化方向的重要进展。通过解耦设计理念,该框架有望推动AI代理训练生态的进一步完善,为构建更加智能和自适应的AI系统奠定基础。