今天凌晨,微軟正式發佈了其最新創新小參數模型Mu。 這款模型參數僅爲3.3億,卻在性能上能與微軟此前發佈的Phi-3.5-mini相媲美,而其體量僅爲Phi-3.5-mini的十分之一。更令人矚目的是,Mu在離線NPU筆記本設備上能實現每秒超過100個token的響應速度,這在小參數模型領域是極爲罕見的突破。

Mu模型的一大亮點是支持在Windows中設置智能體。用戶只需通過自然語言指令,智能體便能實時轉化爲系統操作,例如,一句“把鼠標指針調大一些,調整屏幕亮度”即可讓智能體精準定位並一鍵完成設置調整,極大地提升了Windows系統的易用性。

Mu架構:小型本地部署的卓越優化

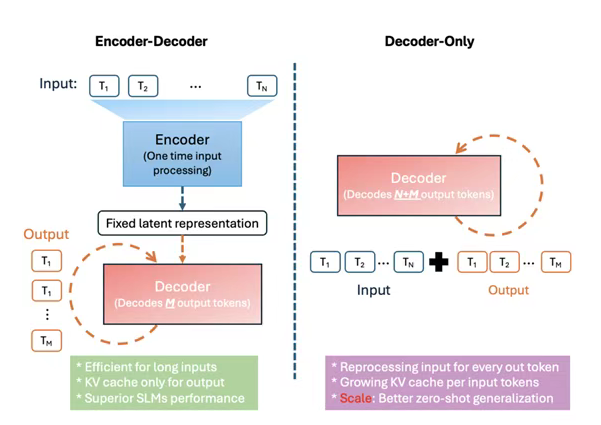

Mu模型借鑑了微軟之前發佈的Phi Silica模型,專爲小型本地部署進行優化,尤其適用於配備NPU的Copilot+ PC。其核心架構爲僅解碼器的Transformer,並在其基礎上引入了三大創新:

- 雙重層歸一化(Dual Layer Normalization):通過在Transformer架構的每個子層前後分別實施LayerNorm操作,有效確保了激活值的分佈具有良好的統計特性,顯著增強了訓練過程的穩定性,避免了深層網絡中常見的訓練不穩定問題,從而提高了訓練效率並降低了資源消耗。

- 旋轉位置嵌入(Rotary Position Embedding, RoPE):相較於傳統的絕對位置嵌入,RoPE通過引入複數域的旋轉操作,將位置編碼變爲動態可擴展的函數映射。這使得模型能直接體現token之間的相對距離,解決了傳統方法在處理超長序列時性能下降的問題,並賦予模型出色的長序列外推能力。

- 分組查詢注意力(Grouped-Query Attention):此優化針對傳統多頭注意力機制中參數和內存消耗大的問題。通過在頭組之間共享鍵(Key)和值(Value),顯著減少了注意力參數的數量和內存佔用,從而降低了在NPU上的延遲和功耗,提高了模型運行效率,同時通過保持頭的多樣性,確保了與傳統多頭注意力機制相當的性能。

此外,Mu模型還採用了預熱穩定衰減時間表和Muon優化器等先進訓練技術來進一步優化性能。微軟使用A100GPU對Mu進行訓練,遵循Phi模型開發中首創的技術,首先在數百億個高質量教育token上進行預訓練,以學習語言的語法、語義和世界知識。爲了進一步提高準確性,Mu還從Phi模型中進行知識蒸餾,實現了顯著的參數效率,參數量僅爲Phi-3.5-mini的十分之一,卻達到了相似的性能。

賦能Windows智能體:低延遲與高精準的完美結合

爲提升Windows系統的易用性,微軟一直致力於打造一個能理解自然語言並無縫修改系統設置的AI智能體。微軟計劃將Mu模型驅動的智能體集成到現有搜索框中,以實現流暢的用戶體驗,這要求對衆多可能的設置實現超低延遲響應。

在測試了多種模型後,Mu因其合適的特性被選中。儘管基線Mu模型在未經微調的情況下精度會下降50%,但微軟通過將訓練規模擴大到360萬個樣本(提升1300倍),並將處理的設置從約50項擴展至數百項,成功彌補了這一差距。通過採用自動化標註的合成方法、帶元數據的提示調優、多樣化措辭、噪聲注入和智能採樣等技術,用於設置智能體的Mu微調模型成功達到了質量目標。測試顯示,Mu模型打造的智能體在Windows設置的理解和執行操作方面表現出色,響應時間控制在500毫秒以內。