在當前身體現智能(Embodied AI)的發展過程中,創建真實且精確縮放的3D 環境至關重要。然而,現有的方法仍主要依賴於人工設計的3D 圖形,這不僅成本高昂,而且缺乏真實感,限制了其擴展性和通用性。

爲了在物理環境中實現通用智能,必須進行真實的模擬、強化學習以及多樣化的3D 資產生成。儘管最近的擴散模型和3D 生成技術顯示出一定的潛力,但許多仍缺乏物理準確性、密閉幾何結構和正確的比例,使其不適合用於機器人訓練環境。

當前3D 生成技術的侷限性

3D 對象生成通常採用三種主要方法:快速生成的前饋生成、高質量的優化方法和從多張圖片進行視圖重建。儘管近期技術在分離幾何與紋理創建方面取得了進展,但許多模型依然優先考慮視覺效果而非真實物理,這使得它們在需要準確縮放和密閉幾何結構的模擬中顯得不足。儘管全景技術已經使得全視角渲染成爲可能,但仍然缺乏互動性。儘管一些工具試圖通過生成資產來增強模擬環境,但其質量和多樣性依然有限,無法滿足複雜身體現智能研究的需求。

EmbodiedGen:開源、模塊化且適用於模擬的解決方案

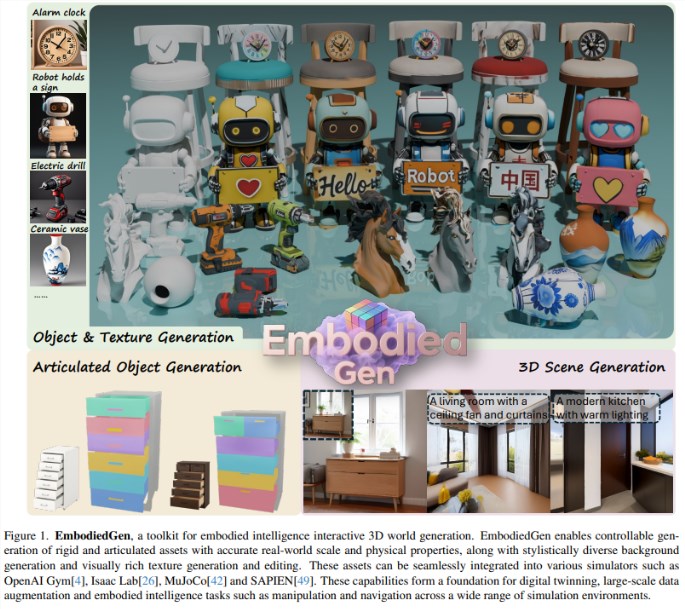

爲了解決這些問題,EmbodiedGen 應運而生。這一由多家機構(包括地平線機器人、香港中文大學、上海齊智研究院和清華大學)共同開發的開源框架,旨在爲身體現智能任務生成真實且可擴展的3D 資產。該平臺能夠輸出物理準確、密閉的3D 對象,格式爲 URDF,並附帶適合模擬的元數據。EmbodiedGen 擁有六個模塊化組件,包括圖像轉3D、文本轉3D、佈局生成和物體重排列,能夠實現可控和高效的場景創建。

多模態生成:豐富的3D 內容

EmbodiedGen 作爲一個多功能工具包,專爲身體現智能任務設計,能夠生成真實且互動的3D 環境。它結合了多種生成模塊,將圖像或文本轉化爲詳細的3D 對象,創建具有可動部件的關節物品,並生成多樣化的紋理以提升視覺質量。此外,EmbodiedGen 支持全面的場景構建,按照真實的物理屬性和比例排列這些資產。輸出結果直接與模擬平臺兼容,使得構建生動的虛擬世界變得更加便捷和經濟,幫助研究人員高效模擬真實場景,而無需依賴昂貴的手動建模。

模擬集成與真實物理準確性

EmbodiedGen 不僅是一個強大且易於訪問的平臺,還能夠生成多樣化的高質量3D 資產,專門用於身體現智能研究。其多個關鍵模塊使用戶能夠從圖像或文本創建資產,生成關節化和紋理化的對象,並構建真實場景。這些資產具有密閉性、照片級真實感和物理準確性,非常適合用於基於模擬的訓練和評估。該平臺支持與包括 OpenAI Gym、MuJoCo、Isaac Lab 和 SAPIEN 在內的主流模擬環境集成,使研究人員能夠以低成本高效地模擬導航、物體操作和避障等任務。

RoboSplatter:高保真3DGS 渲染技術

EmbodiedGen 的一大亮點是 RoboSplatter,該模塊將先進的3D 高斯點雲渲染技術(3DGS)引入物理模擬中。與傳統圖形管道不同,RoboSplatter 在提高視覺保真度的同時,減少了計算開銷。通過紋理生成和真實到模擬(Real-to-Sim)轉換等模塊,用戶可以編輯3D 資產的外觀或重建高真實感的現實場景。總體而言,EmbodiedGen 簡化了可擴展、互動式3D 世界的創建,彌合了現實世界機器人和數字模擬之間的差距。

本研究解決了身體現智能領域的一個核心瓶頸:缺乏可擴展、真實且兼容物理的3D 環境用於訓練和評估。儘管互聯網規模的數據推動了視覺和語言模型的進展,但身體現智能則需要具備準確縮放、幾何形狀和互動性的模擬準備資產,這些特性在傳統的3D 生成管道中往往缺失。

EmbodiedGen 通過提供一個開放源代碼、模塊化的平臺,能夠生成高質量、可控的3D 對象和場景,兼容主流機器人模擬器,填補了這一空白。它將文本和圖像轉化爲可擴展的物理上合理的3D 環境,成爲推動身體現智能研究、數字雙胞胎以及真實到模擬學習的重要工具。

項目:https://horizonrobotics.github.io/robot_lab/embodied_gen/index.html