隨着人工智能的發展,大型語言模型(LLM)的應用越來越廣泛,但目前的推理方式仍然存在不少侷限性。傳統的自迴歸生成方式需要逐個生成 token,效率較低且無法充分利用現代硬件的並行計算能力。爲了解決這一問題,卡耐基梅隆大學(CMU)與英偉達的研究團隊推出了一種名爲 Multiverse 的新型生成模型,旨在實現原生並行生成,從根本上改變我們對 LLM 推理的理解。

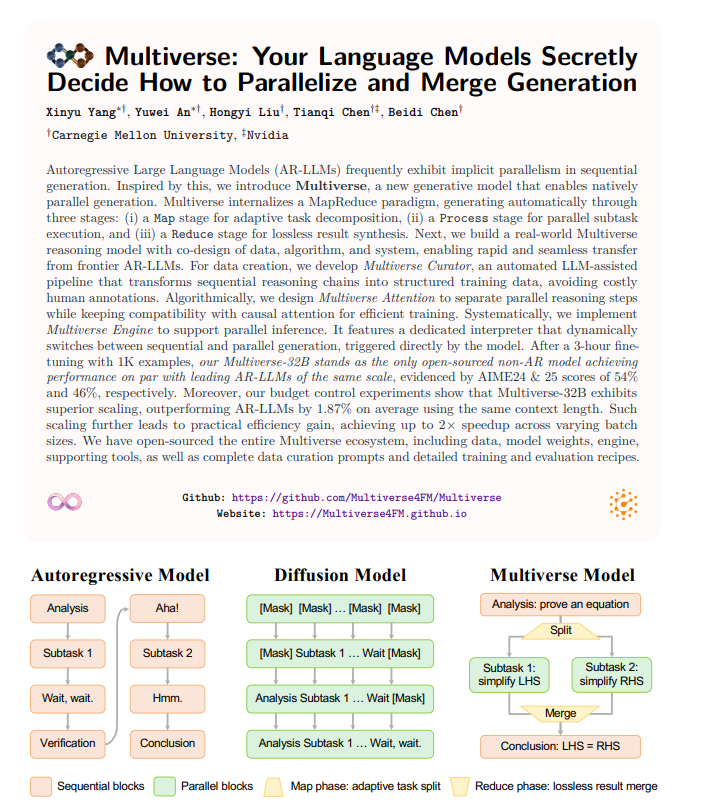

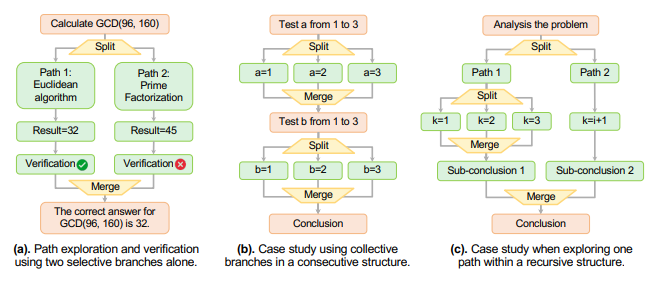

Multiverse 並不僅僅是加快生成速度,而是重新思考了模型的架構。研究者們發現,當前主流的大語言模型在生成過程中其實暗含了一種並行性。通過這一發現,Multiverse 框架採用了類似 MapReduce 的結構,將生成過程分爲三個階段:任務的自適應分解、子任務的並行執行,以及無損結果的合併。這樣的設計能夠充分發揮計算資源的潛力,實現更高效的推理過程。

根據實驗數據顯示,Multiverse-32B 模型在相同的上下文長度下,性能較自迴歸模型提高了近2%。這表明 Multiverse 不僅在速度上有顯著提升,還在擴展性上表現優越,能夠在不同的批量大小下實現最高兩倍的速度提升。爲了讓這一成果能夠更廣泛應用,研究團隊還開源了整個 Multiverse 生態系統,包括數據、模型權重和訓練細節,方便其他研究者進行進一步探索。

在實際應用中,Multiverse 能夠根據生成需求靈活調整,並通過一種專用的控制標籤實現順序與並行生成的動態切換,確保生成內容的連貫性和邏輯性。這項技術的推出無疑爲自然語言處理領域注入了新的活力,讓我們期待它在實際應用中的表現。